AMD oficjalnie zaprezentowało Gaia - nowy, otwartoźródłowy projekt stworzony z myślą o lokalnym uruchamianiu dużych modeli językowych (LLM) na komputerach z systemem Windows. Aplikacja ma być dostępna dla wszystkich użytkowników, ale została dodatkowo zoptymalizowana pod kątem komputerów z procesorami Ryzen AI, w tym z układami Ryzen AI Max 395+.

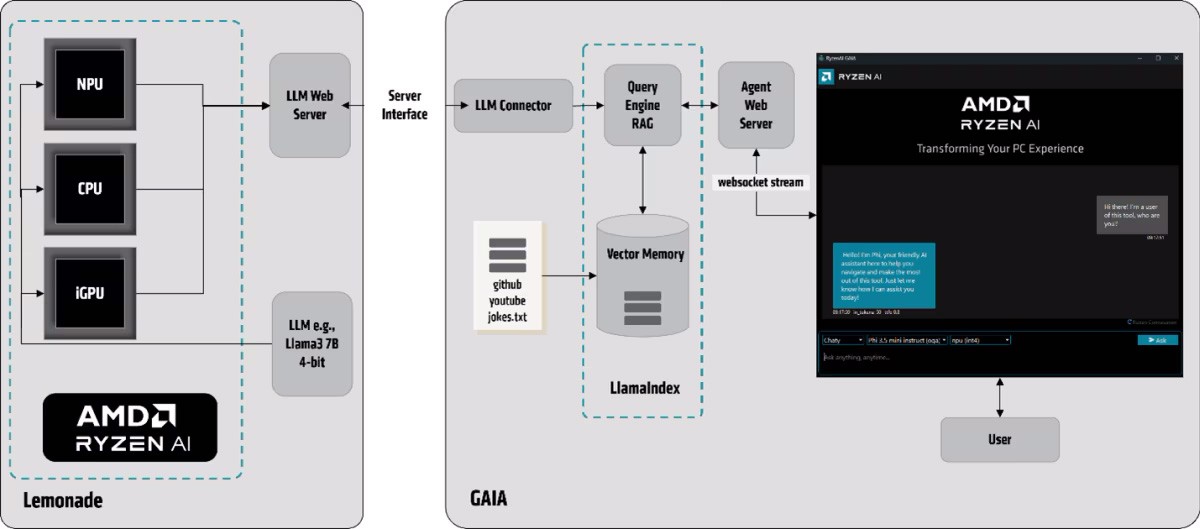

Gaia korzysta z otwartego SDK Lemonade od ONNX TurnkeyML, umożliwiającego wykonywanie zadań opartych na LLM, takich jak podsumowania tekstów, analizowanie danych czy rozumowanie. Najnowszy projekt AMD pozwala na lokalne działanie modeli AI, eliminując konieczność korzystania z chmury i zapewniając większe bezpieczeństwo, mniejsze opóźnienia i pracę offline.

Jak działa Gaia?

Podstawą działania Gaiai jest technika Retrieval-Augmented Generation (RAG), która łączy LLM z lokalną bazą wiedzy. Dzięki temu użytkownik otrzymuje bardziej trafne i kontekstowe odpowiedzi. W ramach projektu udostępniono cztery główne „agenty” Gaia:

-

Simple Prompt Completion – do testów i interakcji z modelem,

-

Chaty – chatbot do rozmów z użytkownikiem,

-

Clip – agent obsługujący wyszukiwanie i pytania o treści z YouTube,

-

Joker – generator żartów dodający humorystyczny charakter do rozmów.

Gaia potrafi także indeksować i przetwarzać lokalne treści (np. pliki tekstowe, dane z GitHuba czy YouTube), przechowując je w postaci wektorowej bazy danych, co pomaga lepiej zrozumieć i odpowiedzieć na zapytania użytkownika.

Dwa warianty instalatora

Aplikacja dostępna jest w dwóch wersjach:

-

Standardowej – kompatybilnej z każdym komputerem z Windows, niezależnie od sprzętu,

-

Hybrid – zoptymalizowanej dla układów Ryzen AI, która umożliwia obliczenia na NPU i zintegrowanej grafice RDNA.

Projekt Gaia dołącza do rosnącej grupy narzędzi do lokalnego uruchamiania LLM, takich jak LM Studio czy ChatRTX, i stanowi ważny krok w popularyzacji niezależnych od chmury rozwiązań AI.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

AMD stawia na sztuczną inteligencję offline. Projekt Gaia przyszłością firmy?