Halucynacje sztucznej inteligencji stają się realnym zagrożeniem dla biznesu, mediów i zaufania społecznego. Ostatnie głośne przypadki w Polsce pokazują skalę problemu, który dotyka już co ósmą osobę w kraju.

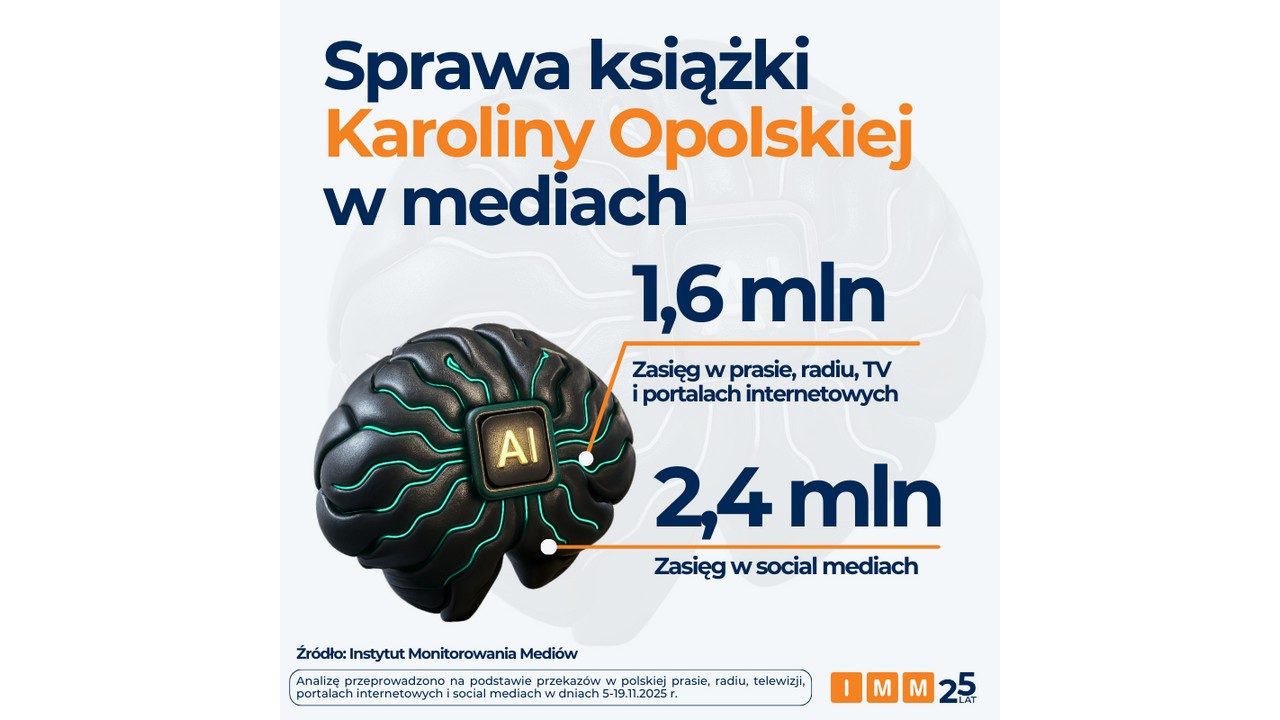

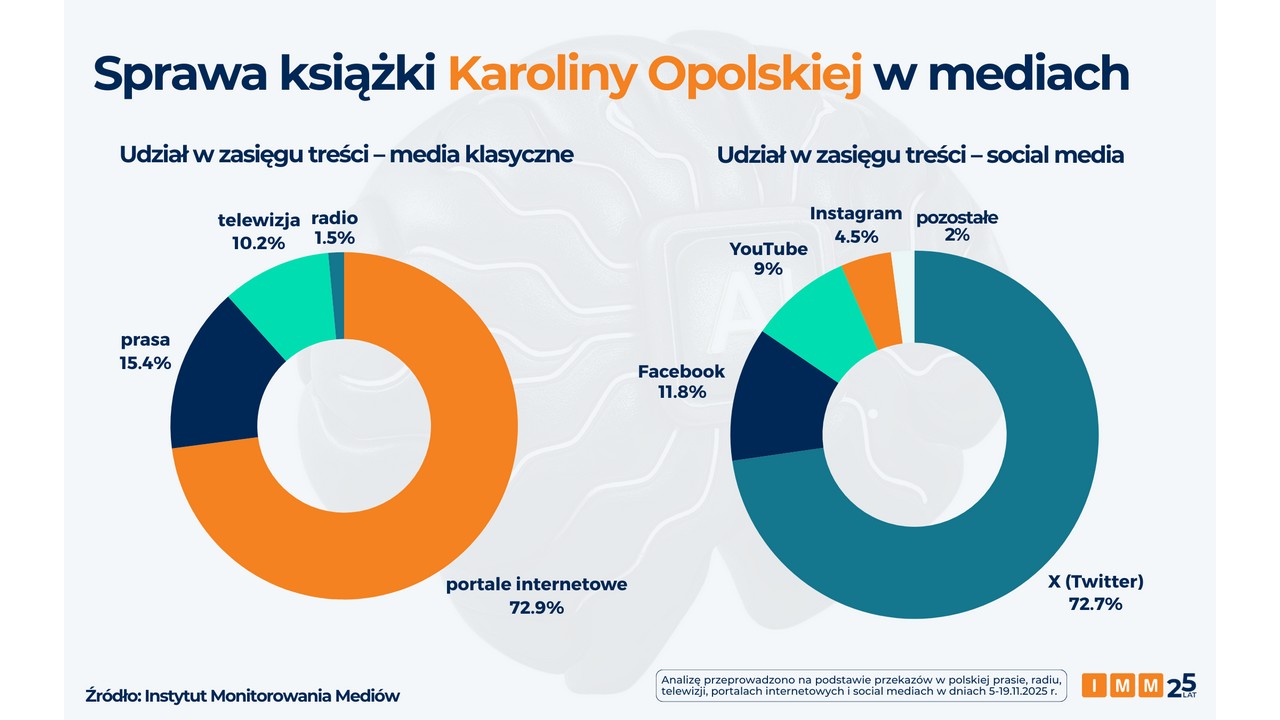

Sprawa dziennikarki Karoliny Opolskiej, której książka zawierała wygenerowane przez AI nieistniejące źródła i błędne informacje, osiągnęła zasięg 4 milionów potencjalnych kontaktów. Według analityków Instytutu Monitorowania Mediów statystycznie dowiedziała się o niej co ósma osoba w Polsce w wieku od 15 lat. To pokazuje, jak szybko dezinformacja może się rozprzestrzeniać.

Jeszcze poważniejsze konsekwencje miała sprawa firmy Exdrog, która została wykluczona z przetargu na utrzymanie dróg. Firma, broniąc podejrzanie niskiej oferty, przedłożyła Krajowej Izbie Odwoławczej dokumentację stworzoną przy pomocy AI. Okazało się, że zawiera ona całkowicie zmyślone interpretacje podatkowe i nieistniejące przepisy prawne. Skutki były realne: strata finansowa i wykluczenie z postępowania.

AI wymyśliło przepisy podatkowe. Firma wyleciała z przetargu drogowego

Problem ma wymiar globalny. Badanie przeprowadzone przez BBC na zlecenie Europejskiej Unii Nadawców przeanalizowało ponad 3000 odpowiedzi wygenerowanych przez najpopularniejsze narzędzia AI - ChatGPT, Microsoft Copilot, Google Gemini i Perplexity. Wynik jest alarmujący: aż 45 procent odpowiedzi zawierało przynajmniej jeden istotny błąd.

Na świecie można znaleźć jeszcze więcej przykładów. Prawnicy powoływali się w sądach na zmyślone precedensy, a "Chicago Sun-Times" opublikował artykuł polecający czytelnikom nieistniejące książki. "Obecne modele AI to potężne narzędzia statystyczne, lecz nie posiadające świadomości ani zrozumienia prawdy. Traktowanie ich jak bezbłędnej wyroczni to recepta na katastrofę wizerunkową i finansową" – ostrzega Tomasz Lubieniecki z IMM.

Wynik jest alarmujący: aż 45 procent odpowiedzi zawierało przynajmniej jeden istotny błąd.

Pojawia się też fundamentalne pytanie o odpowiedzialność prawną. Jak zauważa prof. Justyna Król-Całkowska, obecnie nie ma jasności, kto ponosi winę za szkody wyrządzone przez halucynacje AI: twórca algorytmu, dostawca usługi czy użytkownik, który bezkrytycznie skopiował tekst. Eksperci IMM wskazują na charakterystyczne cechy treści generowanych wyłącznie przez AI, takie jak nadmiernie idealne formatowanie, sensacyjny ton, niewiarygodnie wysokie procenty bez kontekstu metodologicznego, brak ram czasowych danych oraz nadużywanie określonych słów-kluczy charakterystycznych dla modeli językowych.

Szczególnie niebezpieczne są treści wygenerowane w 90-100 procent przez AI, które dotyczą bieżących spraw politycznych, bezpieczeństwa czy biznesu. Tempo ich powstawania nie pozwala na rzetelną weryfikację, co prowadzi do szybkiego rozprzestrzeniania dezinformacji. A wpadek tylko przybywa.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Halucynacje AI dotknęły co ósmą osobę w Polsce. Problem narasta lawinowo