W świecie zaawansowanych technologii pamięci czeka nas prawdziwy skok generacyjny. Koreański Instytut KAIST (Korea Advanced Institute of Science and Technology), jeden z czołowych ośrodków badawczych w Azji, opublikował imponującą, 371-stronicową analizę dotyczącą przyszłości pamięci HBM (High Bandwidth Memory) do 2038 roku. Zanim przejdziemy dalej, warto podkreślić, że dokument nie jest oficjalną mapą drogową żadnego producenta, lecz naukową prognozą bazującą na obecnych trendach badawczych i technologicznych.

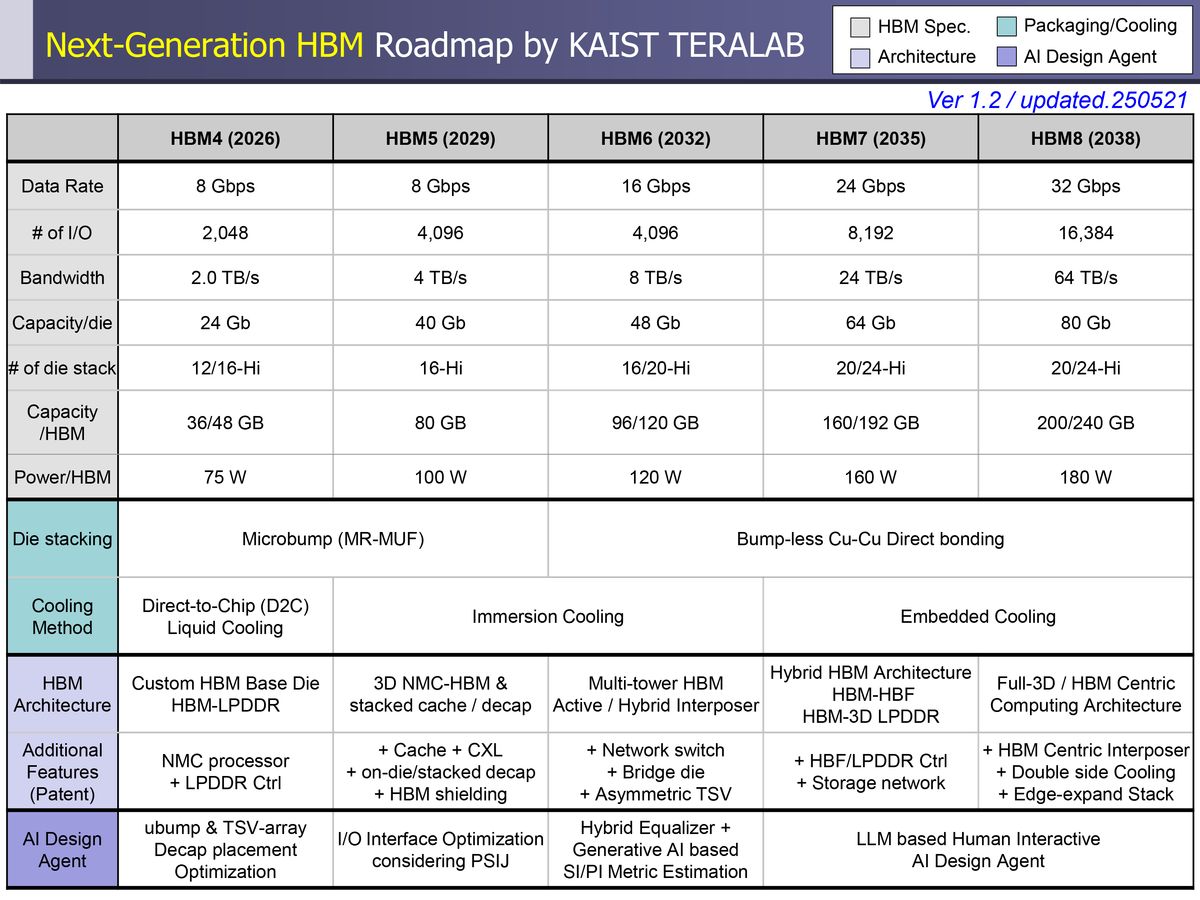

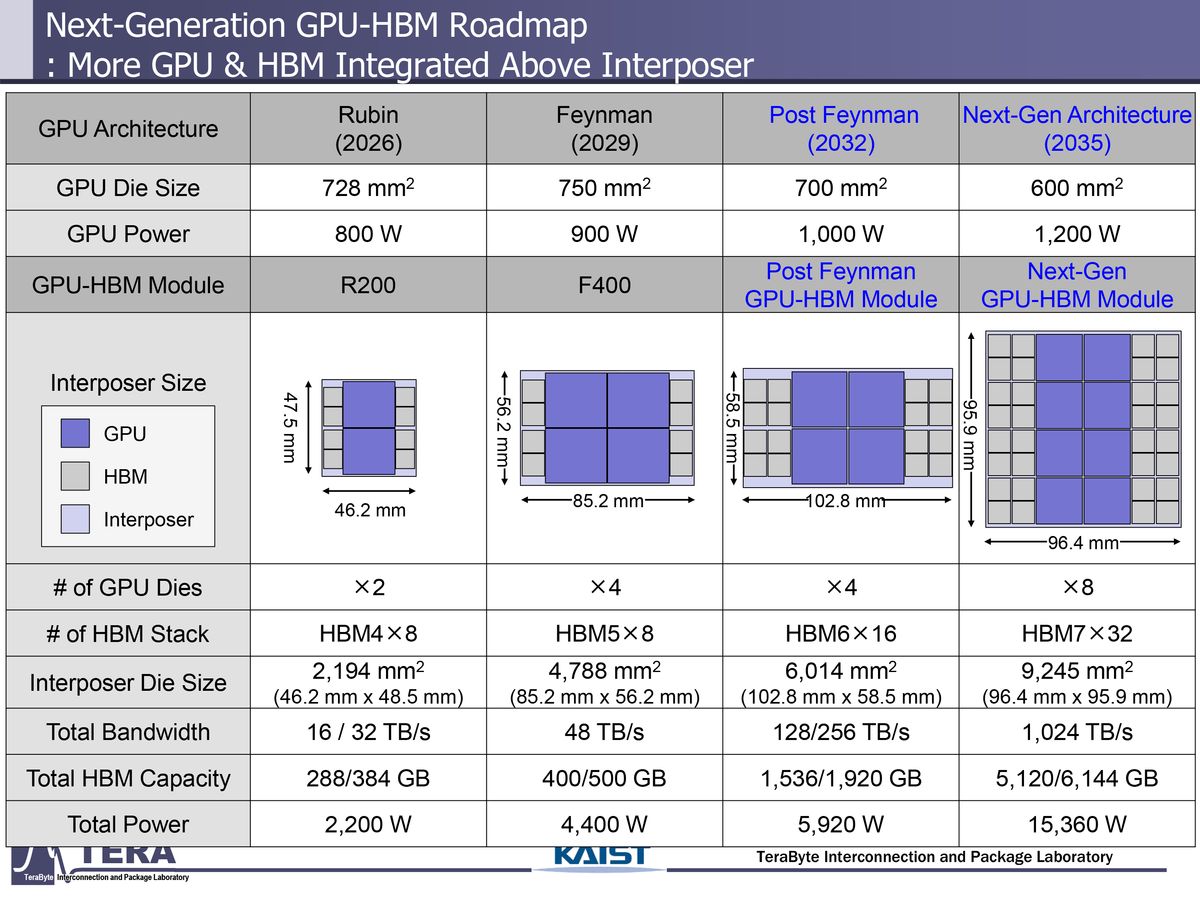

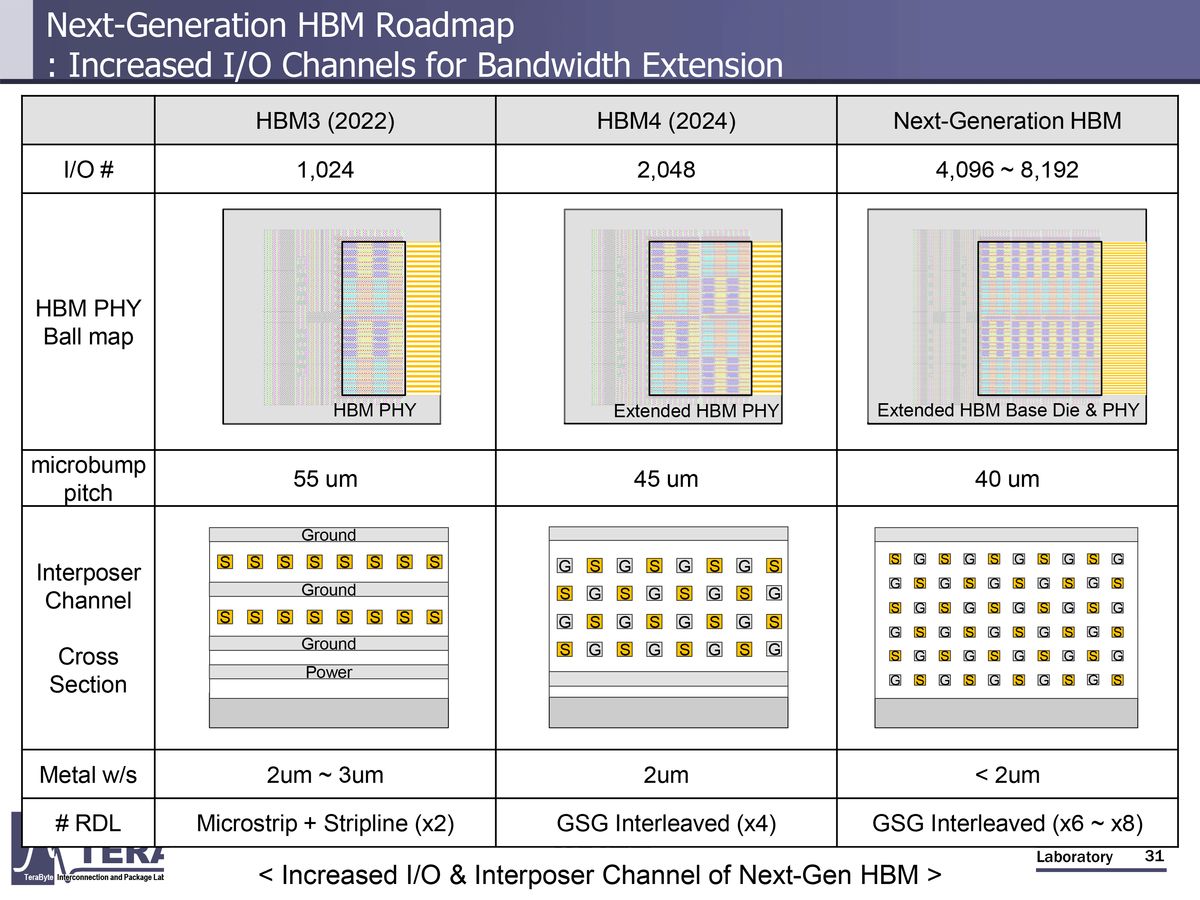

Według prognoz KAIST, przyszłe generacje HBM będą oferować nie tylko większą przepustowość, ale także gigantyczny wzrost pojemności i interfejsów wejścia/wyjścia. Pojemność jednej wieży HBM ma wzrosnąć z 288 GB (HBM4) do nawet 6144 GB (HBM8). Przepustowość pamięci ma natomiast wzrosnąć z 2 TB/s w 2026 roku do 64 TB/s w 2038.

Zwiększona wydajność to również większe zużycie energii i HBM4, według szacunków, będzie pobierać około 75 W na stos, natomiast HBM8 aż 180 W. To stawia przed projektantami nowe wyzwania w zakresie chłodzenia, integracji układów i efektywności energetycznej.

Według prognoz KAIST, przyszłe generacje HBM będą oferować nie tylko większą przepustowość, ale także gigantyczny wzrost pojemności i interfejsów wejścia/wyjścia.

Przełomowa generacja już w 2029?

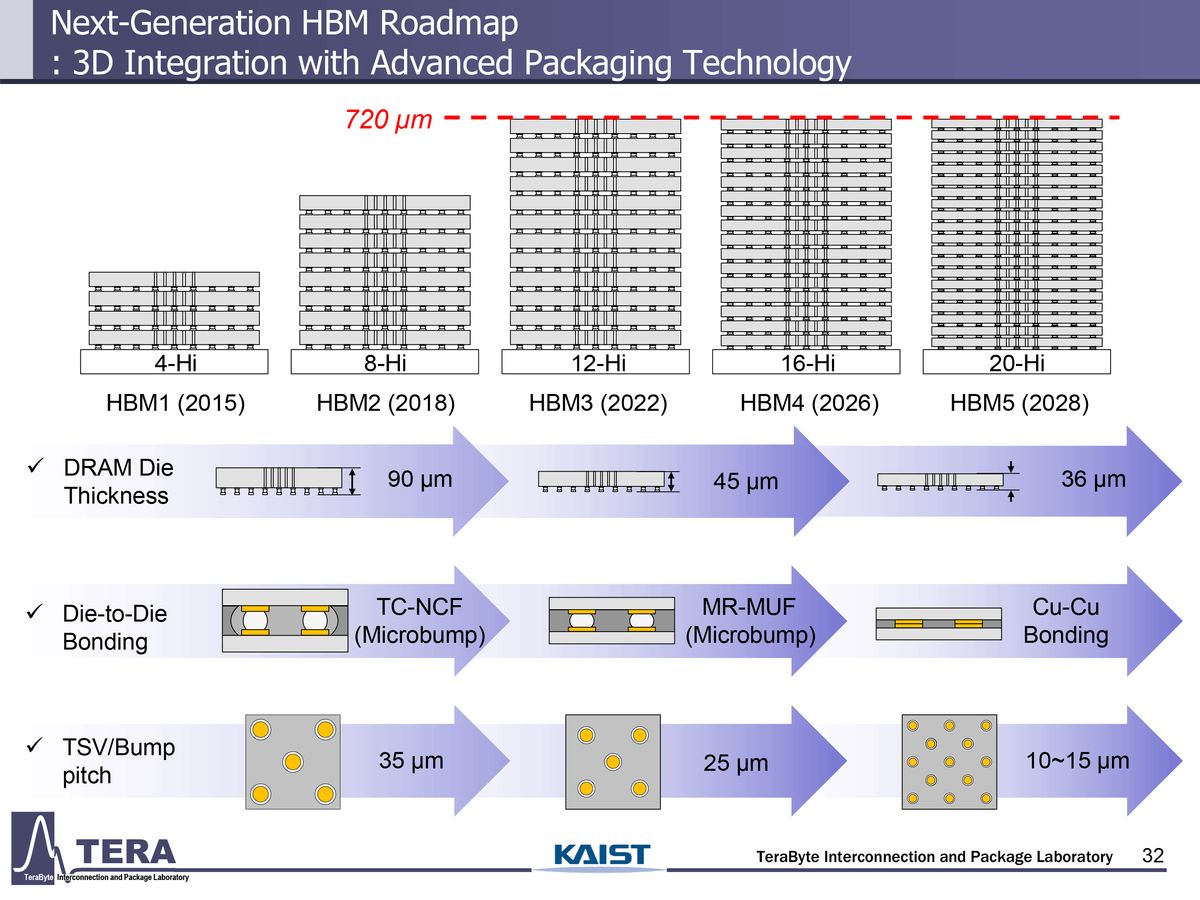

HBM5, spodziewany około 2029 roku, ma stanowić kluczowy krok naprzód. Choć utrzyma przepustowość HBM4 (8 GT/s), to podwoi liczbę linii I/O do 4096, co przełoży się na 4 TB/s przepustowości przy pojemności 80 GB na stos. Ciekawostką jest planowana integracja z innymi typami pamięci (LPDDR) i interfejsami (CXL), a także dodanie pamięci podręcznej L3 bezpośrednio do układu bazowego. HBM5 zachowa technologię mikrobumps (MR-MUF), mimo że HBM4 już flirtuje z bezpośrednim łączeniem warstw.

Już na etapie HBM5 sztuczna inteligencja ma odegrać ważną rolę w projektowaniu fizycznym, w tym optymalizacji układu ścieżek sygnałowych, redukcji jittera i rozmieszczeniu komponentów. W kolejnych generacjach narzędzia AI mają stać się jeszcze bardziej zaawansowane, wykorzystując metody generatywne do modelowania zasilania i sygnałów.

HBM6 i HBM8, czyli pamięć jako centrum systemu

W 2032 roku na rynek ma trafić HBM6 z prędkością przesyłu 16 GT/s i przepustowością 8 TB/s. Nowa generacja będzie korzystać z bezpośredniego łączenia warstw bez bumpów oraz z hybrydowych interpozytorów (krzem + szkło). Pojawią się wielowieżowe struktury pamięci, sieci przełączające wewnątrz układu oraz rozbudowana sieć TSV (Through-Silicon Via), umożliwiająca efektywne przesyłanie danych wewnątrz stosu.

HBM8, ostatni etap przewidywanej ewolucji, ma zaoferować nawet 32 GT/s prędkości transferu oraz interfejs I/O szeroki na 16 384 bity – to osiem razy więcej niż HBM4. Będzie to pamięć zaprojektowana pod najbardziej wymagające zastosowania: przetwarzanie AI, symulacje HPC czy zaawansowane systemy autonomiczne.

Pamięć przyszłości coraz bliżej procesora

Jednym z najciekawszych kierunków rozwoju jest integracja pamięci z funkcjami obliczeniowymi, tzw. architektury memory-centric. KAIST przewiduje, że przyszłe układy HBM będą zawierały także wbudowaną pamięć NAND i elementy logiki, stając się de facto małymi systemami komputerowymi. To całkowicie zmienia sposób, w jaki myślimy o pamięci, nie tylko jako magazynie danych, ale jako aktywnym uczestniku procesów obliczeniowych.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Koreańczycy zapowiadają rewolucję. Nowe standardy pamięci wyprzedzają procesory