Meta opublikowała raport dotyczący szkolenia swojego najnowszego modelu językowego LLM, Llama 3.1 405B, który ujawnia, że proces ten trwał niemal dwa miesiące i wiązał się z licznymi wyzwaniami technicznymi.

Szkolenie modeli LLM, takich jak Llama 3.1 405B, to skomplikowany i czasochłonny proces. Chociaż działanie przeszkolonych algorytmów AI jest stosunkowo szybkie, ich szkolenie może trwać dni, tygodnie, a nawet miesiące, w zależności od rozmiaru modelu. Meta rozpoczęła fazę przedtreningową, która trwała 54 dni. W tym czasie doszło do 466 przestojów, z czego 47 było zaplanowanych, a 419 miało charakter nieplanowany, opóźniając prace.

Jeśli weźmiemy pod uwagę 419 nieplanowanych wyłączeń w ciągu 54 dni, oznacza to średnio jedną taką przerwę co trzy godziny.

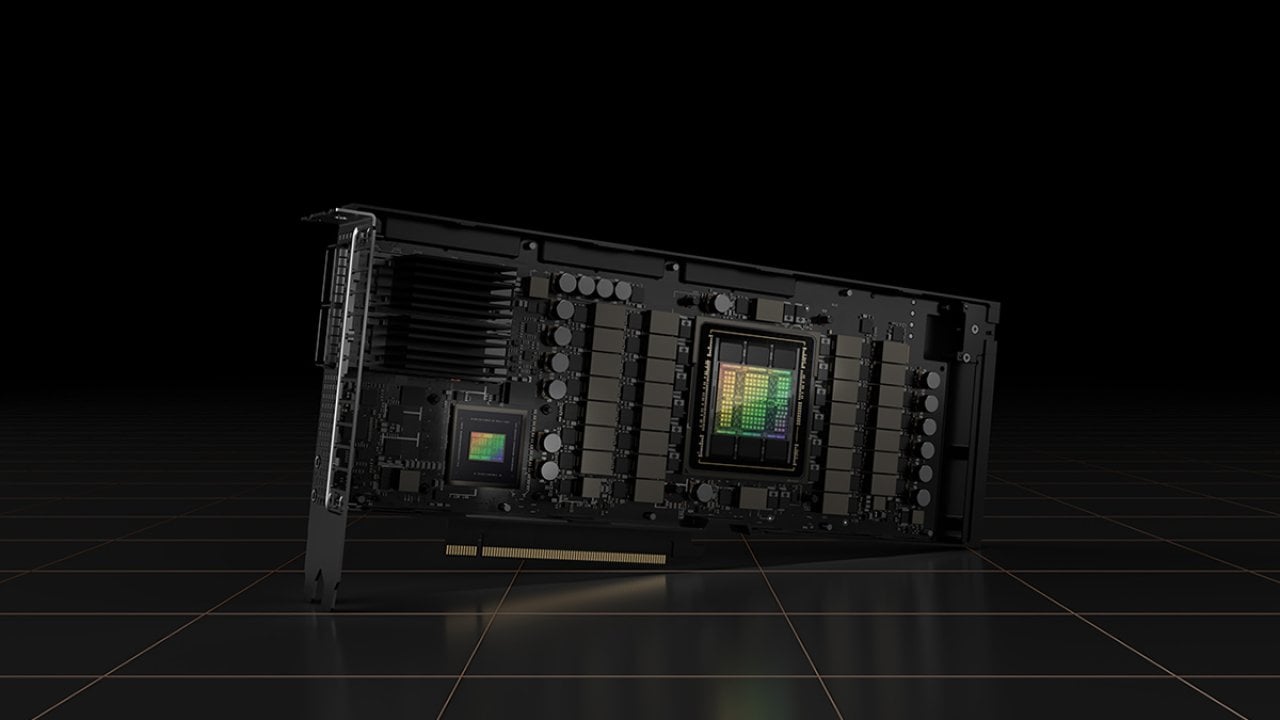

Najwięcej incydentów było związanych z akceleratorami Nvidia H100. Meta wykorzystała tutaj 16 384 procesory graficzne Nvidia H100 z 80 GB pamięci HBM3 i TDP 700 W, które mogłyby teoretycznie pobierać 11,5 MW przy maksymalnym obciążeniu. Błędy GPU były przyczyną 148 nieplanowanych przestojów, co stanowiło 35,3% wszystkich incydentów. Kolejne 72 incydenty były spowodowane błędami w pamięciach HBM3 na tych akceleratorach, co stanowiło 17,2% całości.

Co ciekawe, tylko trzy poważne incydenty wymagały interwencji ręcznej, ponieważ zautomatyzowane systemy nie były w stanie ich rozwiązać. W przypadku awarii pojedynczego układu graficznego konieczne było uruchomienie systemów odzyskiwania, aby uniknąć wznowienia całej dwumiesięcznej pracy. Błędy procesorów były minimalne – odnotowano tylko dwa takie przypadki (0,5%).

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Karty Nvidia H100 przyczyną 50% awarii podczas szkolenia Llama 3.1