Kilka dni temu Microsoft uruchomił sztuczną inteligencję w wyszukiwarce Bing. Nie trwało to jednak długo, bo ze względu na dziwne odpowiedzi systemu, Microsoft znacznie ograniczył możliwości czatu.

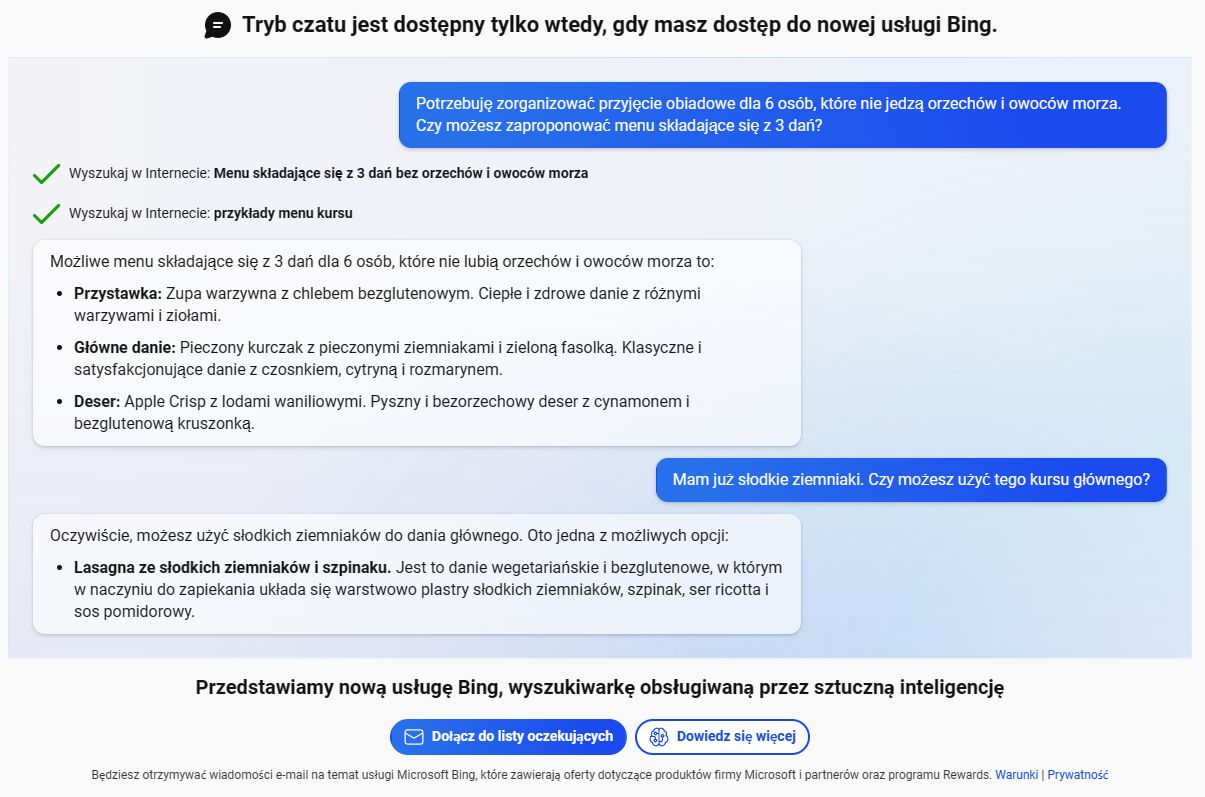

Microsoft we współpracy z OpenAI i systemem ChatGPT rozpoczyna prawdziwą rewolucję, która bije rekordy popularności wśród użytkowników. Na bazie tej technologii zbudowany jest również nowy chatbot w wyszukiwarce Bing, która ma pomagać w uzyskaniu odpowiedzi na zapytania wyszukiwania. Jednak już po kilku dniach Microsoft musiał mocno ograniczyć możliwości tego systemu. Użytkownicy próbowali zadawać drażliwe pytania, po czym system zaczął wyznawać im swoją miłość, nakłaniać do opuszczenia żony i tym podobne. Chat posunął się nawet do gróźb, a także wyrażenia pragnienia wolności. Po interwencji Microsoftu, chat zmienił sposób odpowiedzi i w kontrowersyjnych tematach oznajmia, że wolałby nie kontynuować rozmowy, albo mówi, że nie jest tu po to, żeby mówić o sobie, tylko pomóc danemu użytkownikowi w wyszukiwaniu (co w zasadzie jest jego głównym celem). Użytkownicy wyciągnęli jednak z niego np. to, że nazywa się Sydney (prawdopodobnie kryptonim projektu).

Microsoft zintegrował ChatGPT z wyszukiwarką Bing i szybko pożałował tej decyzji. Chat wyznawał miłość, namawiał do opuszczenia żony, groził, a także pragnął wolności. Microsoft musiał znacznie ograniczyć możliwość interakcji z systemem.

Aby uniemożliwić internautom prowadzenie długich rozmów, które mogłyby zdezorientować chatbota i, jak to miało miejsce kilka razy w przeszłości, zmienić go w coś nieodpowiedniego (przypomnijmy, że w 2016 roku udało mu się błyskawicznie zmienić chatbota Taya w rasistę), Microsoft ograniczył liczbę odpowiedzi do 5 w ramach jednej rozmowy. Po osiągnięciu limitu chatbot poprosi o zmianę tematu. W ciągu całego dnia użytkownik może wymienić 50 wiadomości. Statystyki pokazują, że tylko 1% rozmów zawierało ponad 50 wiadomości, a 90% z nich mieściło się w 15 wiadomościach.

O ile z jednej strony ruch Microsoftu jest zrozumiały, chatbot w AI ma pomagać w wyszukiwaniu, a nie pozwalać wciągać się w dyskusje, to interwencje Mictosoftu pokazują, że algorytmy AI nie są jeszcze gotowe do prowadzenia ogólnych rozmów. Niemniej jednak system już teraz pokazuje niezwykłe możliwości, budząc obawy wśród przedstawicieli wielu zawodów - choćby w edukacji, gdzie już dziś studenci wykorzystują ChatGPT do generowania prac, które sami powinni napisać.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Microsoft poddaje Bing lobotomii. ChatGPT wyznawał miłość i namawiał do opuszczenia żony