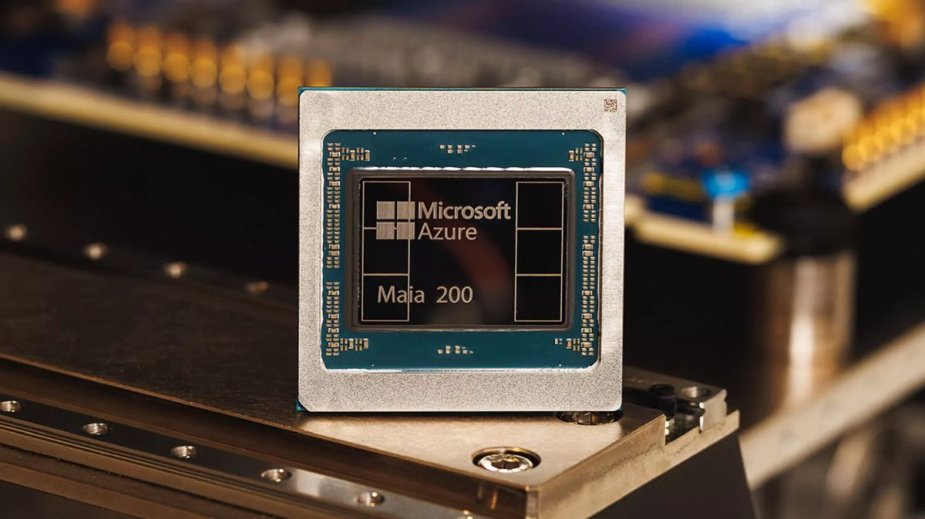

NVIDIA, za sprawą swoich akceleratorów AI, zdominowała rynek, stając się nabardziej wartościową spółką na świecie. Nic więc dziwnego, że inni gracze z segmentu Big Tech zaczęli zadawać sobie jedno pytanie: czy na pewno chcą być od niej całkowicie zależni? Microsoft właśnie wykonał ważny krok w kierunku niezależności, prezentując Maia 200, czyli własny akcelerator AI zaprojektowany z myślą o nowej erze obliczeń.

Nowy układ Microsoftu został zoptymalizowany pod kątem inferencji, czyli etapu, w którym modele AI faktycznie wykonują zadania, a nie są trenowane. Firma deklaruje „dramatyczny” wzrost wydajności w realnych zastosowaniach i potwierdza, że Maia 200 już pracuje w wybranych centrach danych Azure w USA.

Microsoft deklaruje „dramatyczny” wzrost wydajności w realnych zastosowaniach i potwierdza, że Maia 200 już pracuje w wybranych centrach danych Azure w USA.

Specyfikacja robi wrażenie

Maia 200 powstaje w litografii 3 nm TSMC i oferuje natywne rdzenie tensorowe FP8 oraz FP4. Do dyspozycji jest aż 216 GB pamięci HBM3e oraz 272 MB pamięci SRAM na samym chipie. Microsoft twierdzi, że to obecnie najwydajniejszy projekt autorskiego krzemu wykorzystywany przez hyperskalerów.

Maia 200 to prawdziwy kolos: ponad 140 miliardów tranzystorów i TDP sięgające 750 W. W zamian oferuje ponad 10 petaFLOPS mocy obliczeniowej w FP4 oraz ponad 5 petaFLOPS w FP8. Microsoft podkreśla, że SoC zaprojektowano nie tylko pod obecne modele AI, ale również z myślą o znacznie większych konstrukcjach przyszłości.

Duże modele wymagają szybkiej komunikacji, dlatego Maia 200 otrzymała nową architekturę sieciową opartą na Ethernet. Układ integruje własny kontroler sieciowy i niestandardową warstwę transportową, co pozwala osiągnąć nawet 2,8 TB/s dwukierunkowej przepustowości na pojedynczy SoC.

Amazon i Google zostają w tyle

Według danych Microsoftu Maia 200 jest nawet trzykrotnie wydajniejsza od trzeciej generacji Amazon Trainium przy precyzji FP4 oraz przewyższa siódmą generację Google TPU w obliczeniach FP8. Co istotne, nowy układ oferuje też około 30% lepszą relację wydajności do kosztu w porównaniu z poprzednim Maia 100.

AI karmi się danymi - nawet syntetycznymi

Maia 200 wykorzystywana jest również do generowania danych syntetycznych, które posłużą do trenowania kolejnych generacji modeli. To reakcja na obawy branży, że zasoby treści tworzonych przez ludzi w końcu się wyczerpią, prowadząc do niebezpiecznych pętli zwrotnych w uczeniu maszynowym.

SDK dla deweloperów już w drodze

Microsoft zapowiada udostępnienie zestawu narzędzi Maia 200 SDK dla deweloperów i startupów AI. W pakiecie znajdzie się m.in. kompilator, wsparcie dla PyTorch, narzędzia niskopoziomowe oraz symulator układu.

Trend jest dość wyraźny, bo hyperskalerzy projektują własny krzem, chcąc uniezależnić się od NVIDII. Zobaczymy, jak im to wyjdzie, bo na razie Zieloni mają na tym polu kilkuletnią przewagę.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Microsoft prezentuje własnego kolosa AI. Nvidia powinna się martwić?