Zgodnie z oczekiwaniem, dyrektor generalny NVIDII, Jensen Huang, podczas inauguracji GTC 2024 zrzucił bombę w postaci Blackwell B200, czyli nowej generacji GPU dla centrum danych i AI, które zapewnia ogromny skok w mocy obliczeniowej.

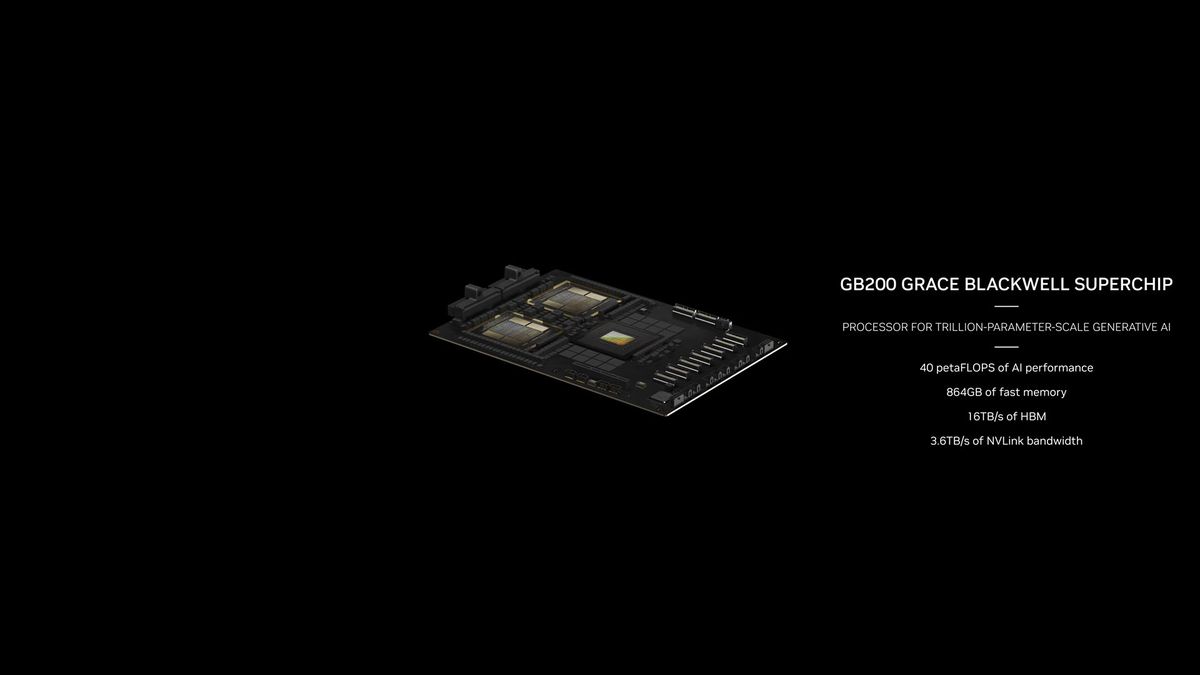

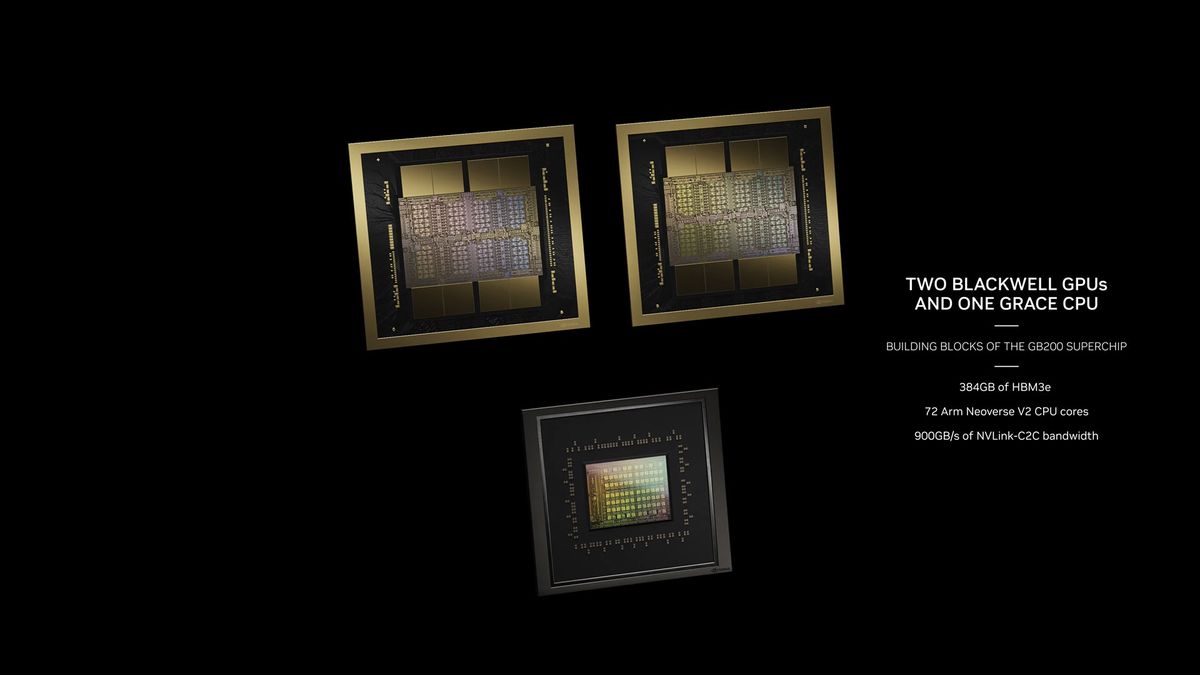

Architektura Blackwell i GPU B200 to następcy H100/H200. Pojawi się także superchip Grace Blackwell GB200, który, jak można się domyślić po nazwie, zachowa architekturę procesora Grace, ale połączy go z nowym układem graficznym Blackwell. Oczywiście później pojawią się też konsumenckie GPU Blackwell, ale może to nastąpić dopiero w 2025 roku.

Na ogólnym poziomie układ graficzny B200 ponad dwukrotnie zwiększa liczbę tranzystorów w porównaniu z istniejącym H100.

Na ogólnym poziomie układ graficzny B200 ponad dwukrotnie zwiększa liczbę tranzystorów w porównaniu z istniejącym H100. Jest kilka zastrzeżeń, do których za chwilę dojdziemy, ale B200 zawiera 208 miliardów tranzystorów (w porównaniu z 80 miliardami w H100/H200). Zapewnia także 20 petaflopów wydajności AI z pojedynczego GPU – pojedynczy H100 miał maksymalnie 4 petaflopy mocy obliczeniowej AI. I co nie mniej ważne, będzie wyposażony w 192 GB pamięci HBM3e, oferując przepustowość 8 TB/s.

Trzeba jednak zaznaczyć, że Blackwell B200 nie jest pojedynczą kartą graficzną w tradycyjnym tego słowa znaczeniu. Zamiast tego składa się z dwóch ściśle połączonych kości, chociaż według NVIDII działają one jako jeden zunifikowany procesor graficzny CUDA. Chipy są połączone za pomocą NV-HBI (Nvidia High Bandwidth Interface) o szybkości 10 TB/s, aby zapewnić ich prawidłowe działanie jako pojedynczego, w pełni koherentnego układu.

Blackwell B200 będzie wykorzystywać litografię 4NP firmy TSMC, udoskonaloną wersję procesu 4N wykorzystywanego przez istniejące GPU o architekturze Hopper H100 i Ada Lovelace. Nie mamy zbyt wielu szczegółów na temat TSMC 4NP, ale prawdopodobnie nie zapewnia on znacznej poprawy w zakresie gęstości, co oznacza, dlatego też zapewne Zieloni zdecydowali się na taką nietypową podwójną konfigurację, chcąc osiągnąć duży skok w zakresie wydajności.

B200 będzie korzystał z dwóch chipów o pełnym rozmiarze, chociaż NVIDIA nie podała jeszcze dokładnego rozmiaru matrycy. Każda kość ma cztery stosy HMB3e po 24 GB każdy, z przepustowością 1 TB/s każdy na 1024-bitowej szynie. Należy zauważyć, że H100 miał sześć stosów HBM3 po 16 GB każdy (początkowo — H200 zwiększył tę liczbę do sześciu po 24 GB), co oznacza, że pewna część kości H100 była przeznaczona dla sześciu kontrolerów pamięci. Rezygnując z czterech interfejsów HBM na chip i łącząc ze sobą dwa chipy, producent może przeznaczyć proporcjonalnie mniej obszaru kości na interfejsy pamięci.

Drugie zastrzeżenie, o którym trzeba wspomnieć, dotyczy maksymalnej teoretycznej mocy obliczeniowej wynoszącej 20 petaflopów. Blackwell B200 osiąga ten wynik dzięki nowemu formatowi liczb FP4, z dwukrotnie większą przepustowością niż format FP8 Hoppera H100. Tak więc, jeśli porównamy te same wartości i pozostaniemy przy 8PR, B200 oferuje już „tylko” 2,5 razy wyższą moc obliczeniową 8PR niż H100, a duża część tego wynika z posiadania dwóch chipów.

B200 teoretycznie zapewnia 1,25 razy więcej mocy obliczeniowej na chip w przypadku większości formatów liczb obsługiwanych zarówno przez H100, jak i B200. Usunięcie dwóch interfejsów HBM3 i utworzenie nieco większego chipa może oznaczać, że gęstość obliczeniowa nie będzie nawet znacząco wyższa na poziomie chipa – choć oczywiście interfejs NV-HBI pomiędzy dwoma chipami również zajmuje pewną część obszaru matrycy.

A co z przepustowością FP64? H100 zapewnia 60 teraflopów mocy obliczeniowej FP64 na procesor graficzny. Gdyby B200 miał podobne skalowanie jak inne formaty, nowy procesor graficzny z podwójną matrycą miałby 150 teraflopów. Wygląda jednak na to, że NVIDIA nieco zmniejsza wydajność FP64, osiągając 45 teraflopów FP64 na GPU, co w tym przypadku przekłada się na 90 teraflopów dla podwójnego układu.

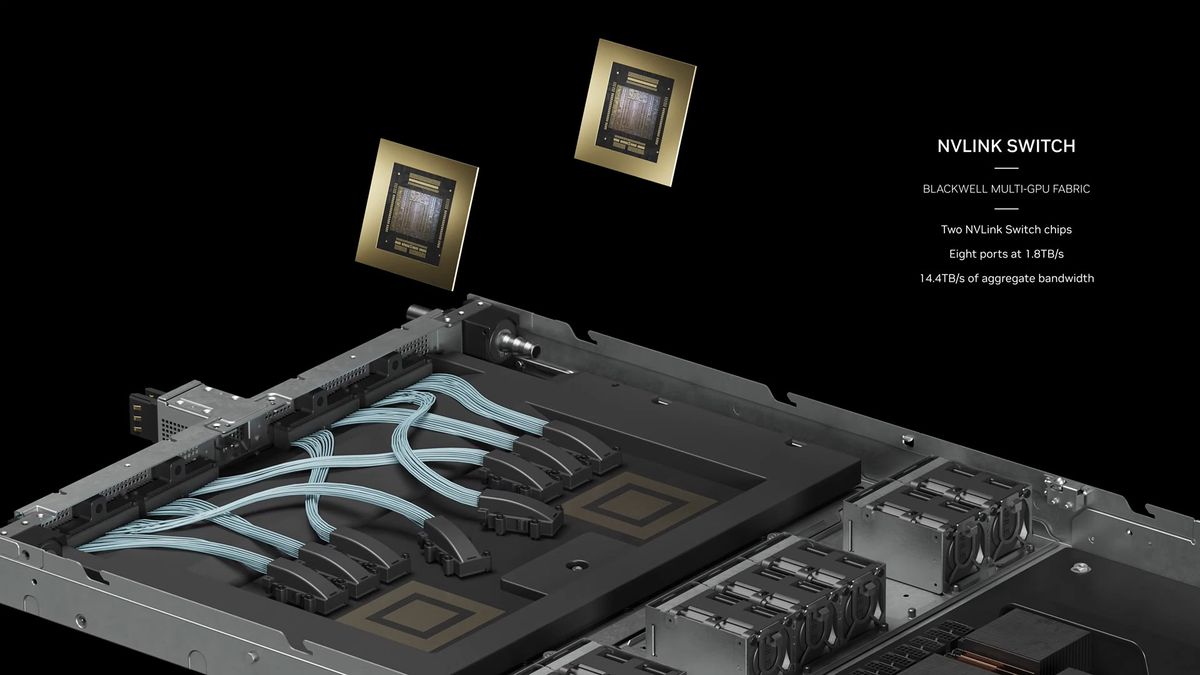

Warto również wyjaśnić, że dostępnych jest wiele różnych wariantów Blackwell. Początkowo Nvidia udostępnia specyfikacje dotyczące pełnych węzłów serwerowych i istnieją trzy główne opcje. Największym i najwydajniejszym rozwiązaniem będzie superchip GB200, o którym szerzej porozmawiamy poniżej. Pełny superchip posiada konfigurowalne TDP aż do 2700 W. To dotyczy dwóch układów graficznych (cztery kości GPU) i jednego procesora Grace. Nie jest jasne, jakie jest TDP dla pojedynczego GPU B200 w tej konfiguracji, ale potencjalnie wynosi ono do 1400 W.

Następną opcją Blackwella jest HGX B200, który opiera się na wykorzystaniu ośmiu GPU B200 z CPU x86 (prawdopodobnie dwóch procesorów) w jednym węźle serwerowym. Są one skonfigurowane z mocą 1000 W na procesor graficzny B200, a GPU oferują do 18 petaflopów przepustowości FP4.

Jest także HGX B100 z procesorem x86 i ośmioma GPU B100, z tą różnicą, że ta opcja została zaprojektowana tak, aby była kompatybilna z istniejącą infrastrukturą HGX H100 i umożliwia najszybsze wdrożenie układów graficznych Blackwell. W związku z tym TDP na procesor graficzny jest ograniczone do 700 W, tak samo jak w H100, a przepustowość spada do 14 petaflopów FP4 na procesor graficzny.

Niestety NVIDIA nie ujawniła jeszcze żadnych szczegółów na temat liczby rdzeni CUDA lub jednostek SM dostępnych w którymkolwiek z GPU Blackwell.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

NVIDIA prezentuje pierwsze GPU nowej generacji Blackwell. Nawet 4 razy szybsze niż Hopper