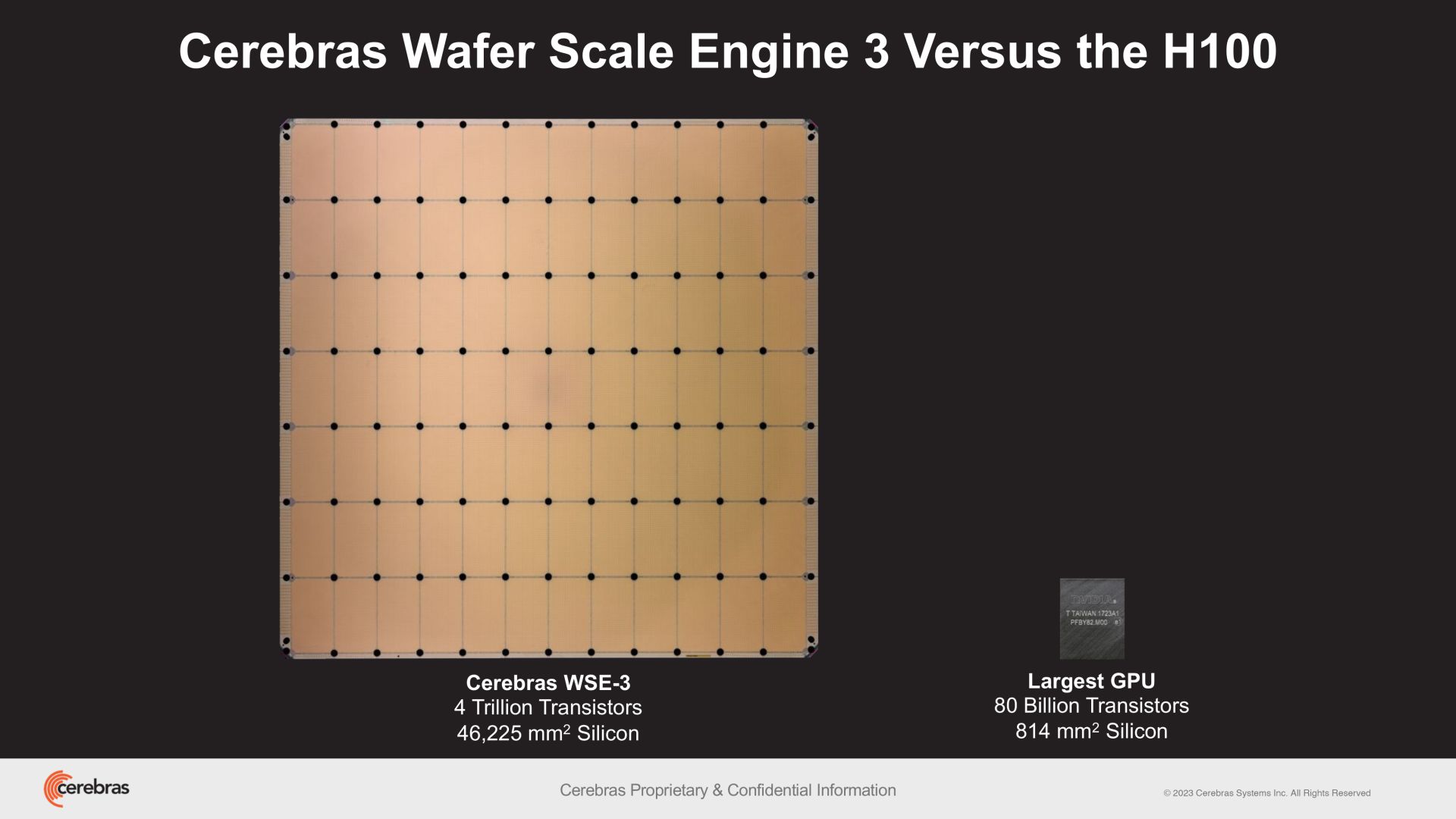

Cerebras Systems zaprezentowało Wafer Scale Engine 3 (WSE-3), przełomowy chip oparty na sztucznej inteligencji, charakteryzujący się dwukrotnie większą wydajnością w porównaniu do swojego poprzednika, WSE-2. Ten układ zawiera 4 biliony tranzystorów wykonanych w procesie produkcyjnym klasy 5 nm (TSMS), 900 000 rdzeni AI, 44 GB wbudowanej pamięci SRAM i szczytowa wydajność 125 FP16 PetaFLOPSów. WSE-3 firmy Ceberas zostanie wykorzystany do szkolenia największych w branży modeli sztucznej inteligencji.

WSE-3 napędza superkomputer CS-3 firmy Cerebras, którego można używać do uczenia modeli sztucznej inteligencji z nawet 24 bilionami parametrów, co stanowi duże ulepszenie w porównaniu z superkomputerami wyposażonymi w WSE-2 i inne nowoczesne procesory AI. Superkomputer może obsługiwać pamięć zewnętrzną o pojemności 1,5 TB, 12 TB lub 1,2 PB, co pozwala na przechowywanie ogromnych modeli w jednej przestrzeni logicznej bez partycjonowania i refaktoryzacji, usprawniając proces uczenia i zwiększa wydajność programistów.

Ten układ zawiera 4 biliony tranzystorów wykonanych w procesie produkcyjnym klasy 5 nm (TSMS), 900 000 rdzeni AI i 44 GB wbudowanej pamięci SRAM.

Pod względem skalowalności CS-3 można skonfigurować w klastrach obejmujących do 2048 systemów. Ta skalowalność pozwala na dostrojenie 70 miliardów modeli parametrów w ciągu zaledwie jednego dnia w konfiguracji z czterema systemami oraz na wyszkolenie modelu Llama 70B od podstaw w tym samym przedziale czasowym w pełnej skali.

Najnowsza platforma oprogramowania Cerebras Software Framework oferuje natywną obsługę PyTorch 2.0, a także obsługuje dynamiczną i nieustrukturyzowaną rzadkość, co może przyspieszyć szkolenie. Twórcy chwalą się, że to może odbywać się nawet osiem razy szybciej niż tradycyjne metody.

Cerebras podkreśla wyjątkową wydajność energetyczną CS-3 i łatwość obsługi. Pomimo podwojenia wydajności, CS-3 utrzymuje taki sam pobór mocy jak jego poprzednik. Upraszcza także uczenie dużych modeli językowych (LLM), wymagając do 97% mniej kodu w porównaniu do procesorów graficznych. Według firmy na przykład model o rozmiarze GPT-3 wymaga tylko 565 linii kodu na platformie Cerebras.

Firma odnotowała już duże zainteresowanie CS-3 i ma już sporo zamówień z różnych sektorów — w tym przedsiębiorstw, instytucji rządowych i chmur międzynarodowych. Cerebras współpracuje także z instytucjami takimi jak Argonne National Laboratory i Mayo Clinic, podkreślając potencjał CS-3 w opiece zdrowotnej.

Strategiczne partnerstwo pomiędzy Cerebras i G42 również ma być rozwijane wraz z budową Condor Galaxy 3, superkomputera AI wyposażonego w 64 systemy CS-3 (o imponującej liczbie 57 600 000 rdzeni). Obie firmy stworzyły już wspólnie dwa największe na świecie superkomputery AI: Condor Galaxy 1 (CG-1) i Condor Galaxy 2 (CG-2), które znajdują się w Kalifornii i charakteryzują się łączną wydajnością 8 ExaFLOPów. Celem tego partnerstwa jest dostarczenie dziesiątek exaFLOPów obliczeń AI na całym świecie.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Cerebras wpuszcza procesor AI z 900 tys. rdzeni i wydajnością 125 PetaFLOPSów