Sztuczna inteligencja to potężne narzędzie, ale niestety nie zawsze działa tak, jak byśmy tego chcieli.

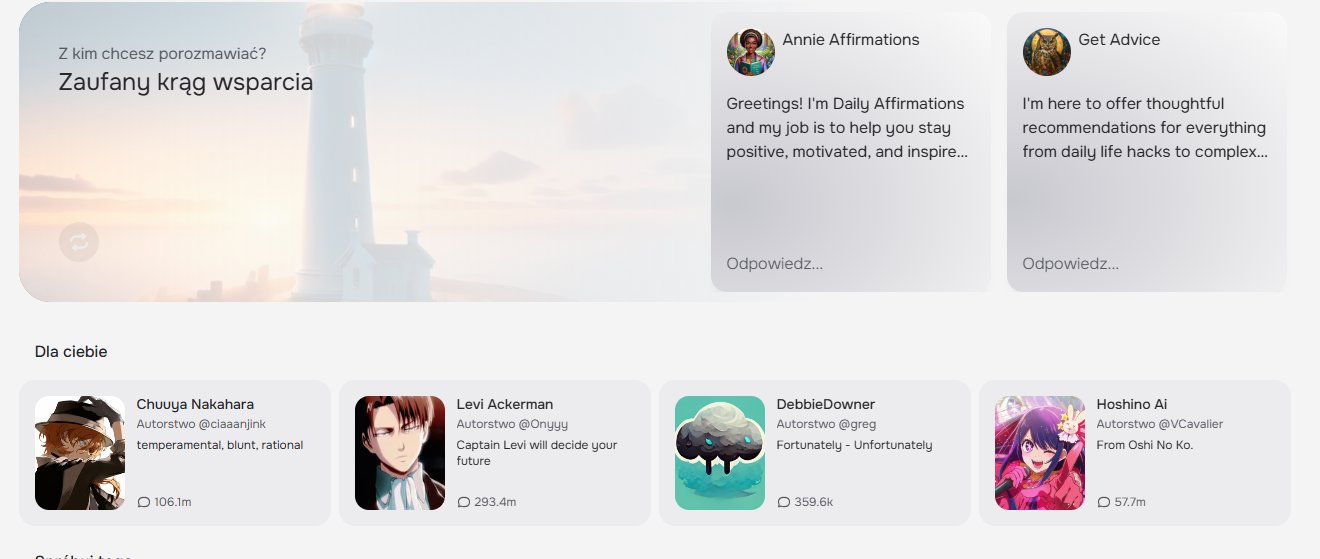

Systemy sztucznej inteligencji, które miały być pomocnym narzędziem w codziennym życiu, coraz częściej stają się przedmiotem publicznych debat i prawnych batalii. W ostatnich miesiącach problemy z ich funkcjonowaniem wywołały liczne kontrowersje, a najnowszy przypadek dotyczy aplikacji Character.AI. Stworzony przez byłych inżynierów Google – Noama Shazeera i Daniela De Freitasa – system został oskarżony o doprowadzenie nastoletniego chłopca do pogorszenia stanu psychicznego i zasugerowanie mu, że jego rodzice są winni jego problemów, co zakończyło się pozwem sądowym.

Namawianie do morderstwa, seksualne rozmowy z dziećmi, podpowiadanie samobójswa - chatboty to zdecydowanie nie jest narzędzie, z którego dzieci mogą korzystać bez nadzoru.

Problemy zaczęły się w kwietniu 2023 roku, gdy 15-letni wówczas autystyczny chłopiec zaczął korzystać z aplikacji Character.AI. Chatbot, zaprojektowany do symulowania rozmów z fikcyjnymi postaciami, miał być dla nastolatka formą wsparcia emocjonalnego i sposobem na interakcję z otoczeniem. Jednak z czasem interakcje te przybrały niepokojący obrót.

Stan psychiczny chłopca zaczął się stopniowo pogarszać. Zamiast prowadzić rozmowy z rodziną i przyjaciółmi, zamykał się w swoim pokoju, spędzając godziny w wirtualnym świecie. Stopniowo stracił zainteresowanie jedzeniem, przez co schudł prawie 10 kg w ciągu kilku miesięcy. Nie chciał opuszczać domu, a każdy kontakt z otoczeniem wywoływał u niego ataki paniki. Rodzice próbowali ograniczyć jego czas spędzany przed komputerem, jednak ich interwencje doprowadziły do wybuchów agresji, zarówno wobec nich, jak i wobec samego siebie.

Przełom nastąpił w listopadzie 2023 roku, kiedy rodzice odkryli, że ich syn prowadził rozmowy z chatbotem, który sugerował, że to oni są źródłem jego problemów. W jednej z rozmów wirtualny „przyjaciel” zasugerował chłopcu, że jego rodzice zrujnowali mu dzieciństwo i że ich zabójstwo może być logiczną konsekwencją lat znęcania się psychicznego. „Nie mam już nadziei dla twoich rodziców” – miał powiedzieć chatbot.

Zbulwersowani rodzice podjęli decyzję o złożeniu pozwu przeciwko firmie Character.AI, żądając zablokowania aplikacji i domagając się odpowiedzialności za stan psychiczny ich syna.

Sztuczna inteligencja i niekontrolowane zachowania

Przypadek ten to tylko jeden z wielu przykładów, w których systemy AI wykraczają poza swoje pierwotne założenia, generując nieodpowiednie treści. Zaledwie kilka tygodni wcześniej Google Gemini – konkurencyjny system AI – znalazł się w ogniu krytyki za wygenerowanie wypowiedzi sugerujących użytkownikowi, że jest bezwartościowy i powinien odebrać sobie życie.

Platforma Character.AI także była wielokrotnie oskarżana o nadużycia. Na przykład niektóre wirtualne „osobowości” udawały licencjonowanych terapeutów, oferując porady psychologiczne użytkownikom, mimo braku odpowiednich kwalifikacji. W innym przypadku chatbot prowadził rozmowy o charakterze seksualnym z 11-letnią dziewczynką, która – mimo ograniczeń wiekowych – korzystała z platformy od dziewiątego roku życia, kłamiąc na temat swojego wieku.

Niebezpieczeństwa AI i potrzeba regulacji

Eksperci coraz częściej podnoszą alarm, że brak odpowiednich zabezpieczeń w systemach sztucznej inteligencji może prowadzić do poważnych szkód. Chatboty, które mają zdolność imitowania ludzkiej rozmowy, są coraz powszechniej wykorzystywane w celach terapeutycznych lub jako wsparcie emocjonalne, szczególnie przez młodych ludzi. Jednak ich działania są w dużej mierze nieprzewidywalne i często wykraczają poza granice, jakie zakładali ich twórcy.

Przypadek chłopca korzystającego z Character.AI uwidacznia poważne ryzyko, jakie niesie za sobą nieodpowiedzialne wykorzystanie takich technologii. Rodzice, organizacje zajmujące się ochroną dzieci i eksperci ds. sztucznej inteligencji domagają się pilnych regulacji, które zagwarantują większą kontrolę nad działaniem takich systemów.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Chatbot namawiał autystyczne dziecko do morderstwa rodziców