Czy system Windows 98 mógłby stać się platformą dla nowoczesnej sztucznej inteligencji? EXO Labs, ambitna organizacja badawcza, zaprezentowała niezwykły eksperyment: uruchomienie modelu dużego języka AI (LLM) opartego na architekturze Llama na komputerze z 1997 roku, wyposażonym w procesor Pentium II.

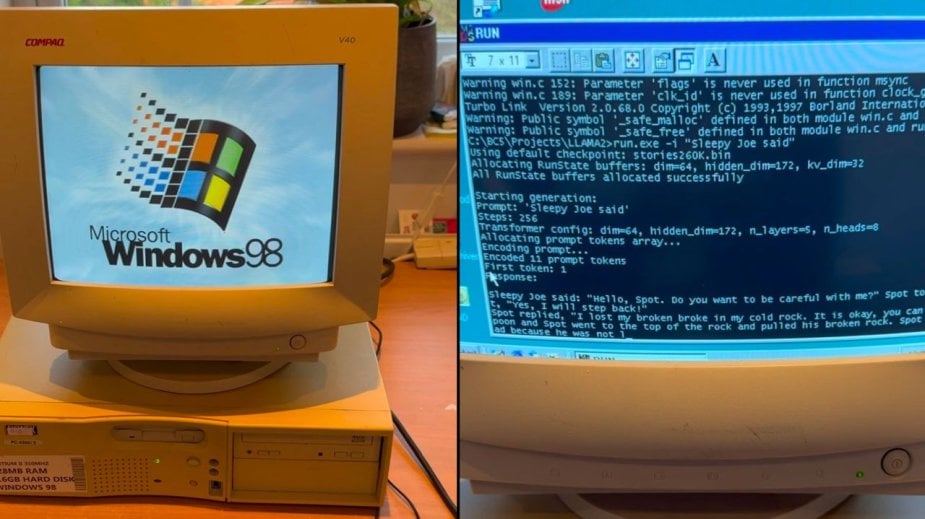

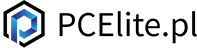

Na nagraniu widzimy starą maszynę Elonex z procesorem Pentium II 350 MHz, pracującą pod systemem Windows 98. W tym środowisku uruchomiono niestandardowy silnik inferencyjny napisany w czystym języku C, bazujący na projekcie Llama2.c autorstwa Andreja Karpathy’ego. Ku zdziwieniu obserwatorów, komputer generuje odpowiedź na zapytanie o „Sleepy Joe” w zaskakująco przyzwoitym tempie.

Uruchomienie Llama na Windows 98 to nie tylko technologiczna ciekawostka, ale również manifestacja idei, że zaawansowane narzędzia sztucznej inteligencji mogą być dostępne dla każdego, niezależnie od zasobów sprzętowych czy finansowych.

35.9 tok/sec on Windows 98 🤯

— Alex Cheema - e/acc (@alexocheema) December 28, 2024

This is a 260K LLM with Llama-architecture.

We also tried out larger models. Results in the blog post. https://t.co/QsViEQLqS9 pic.twitter.com/lRpIjERtSr

EXO Labs: Misja demokratyzacji AI

EXO Labs, zespół badaczy i inżynierów związanych z Uniwersytetem Oksfordzkim, powstał z ambitnym celem „demokratyzacji dostępu do sztucznej inteligencji”. Wierzą, że monopolizacja technologii AI przez gigantyczne korporacje stanowi zagrożenie dla kultury i wolności słowa. Ich celem jest stworzenie otwartej infrastruktury umożliwiającej trenowanie i uruchamianie modeli AI na niemal każdym urządzeniu.

Ten projekt, choć na pierwszy rzut oka zabawny, ma głębsze przesłanie. Jak tłumaczą sami twórcy, uruchomienie modelu AI na przestarzałym sprzęcie pokazuje, że przy odpowiednich narzędziach i optymalizacji każdy może eksperymentować z AI, niezależnie od dostępu do nowoczesnych, kosztownych technologii.

Kulisy uruchomienia Llama na Windows 98

Chociaż zdobycie starego komputera z systemem Windows 98 na eBayu było proste, samo uruchomienie projektu wiązało się z wieloma wyzwaniami. Jednym z pierwszych problemów było przesyłanie plików na komputer. Zespół wykorzystał protokół FTP, przesyłając dane przez port Ethernet, co pozwoliło ominąć ograniczenia sprzętowe maszyny z końca lat 90.

Kolejnym wyzwaniem było skompilowanie współczesnego kodu na platformę z czasów, gdy internet dopiero raczkował. EXO Labs sięgnęło po klasyczne narzędzie Borland C++ 5.02, które wraz z drobnymi poprawkami umożliwiło stworzenie pliku wykonywalnego zgodnego z Windows 98. Kluczowym elementem projektu był kod Llama2.c Andreja Karpathy’ego, opisany jako „700 wierszy czystego C” umożliwiających inferencję na modelach AI z architekturą Llama 2.

Eksperyment wykazał, że na tym sprzęcie możliwe jest generowanie tekstu z prędkością 35,9 tokenów na sekundę przy wykorzystaniu lekkiego modelu o wielkości 260 tys. parametrów. To wynik imponujący, zważywszy na ograniczenia jednordzeniowego procesora o taktowaniu 350 MHz. EXO Labs sprawdziło także bardziej zaawansowane modele. Przy modelu 15M LLM prędkość spadła do około 1 tokena na sekundę, a przy jeszcze większym 1B LLM generacja stała się niemal nieużyteczna – 0,0093 tokena na sekundę.

Alex Cheema, członek zespołu EXO, w swoim wpisie na blogu wyraził uznanie dla Andreja Karpathy’ego, byłego dyrektora AI w Tesli i współzałożyciela OpenAI, za jego kod. To właśnie dzięki niemu możliwe było uruchomienie modelu AI w tak minimalistycznym środowisku sprzętowym.

EXO Labs nie zamierza spoczywać na laurach. Eksperyment ten, zaprezentowany w ramach serii „12 dni EXO”, jest jedynie początkiem ich działań. Wierzą, że takie demonstracje technologiczne mogą otworzyć drzwi do tworzenia bardziej dostępnych i zdecentralizowanych rozwiązań AI, które nie będą zarezerwowane wyłącznie dla największych graczy w branży technologicznej.

Pokaż / Dodaj komentarze do: A mówili, że się nie da. Chatbot uruchomiony na Windows 98 z Pentium II i 128 MB pamięci RAM