ChatGPT to narzędzie AI, które potrafi odpowiedzieć na niemal każde pytanie. Jednak istnieje kilka nazwisk, które sprawiają, że model językowy po prostu „się poddaje”. Powody tego zjawiska związane są z tendencją AI do generowania nieprawdziwych informacji oraz potencjalnymi konsekwencjami prawnymi, szczególnie w kontekście fałszywych oskarżeń wobec osób.

Użytkownicy mediów społecznościowych odkryli niedawno, że wprowadzenie nazwiska „David Mayer” powodowało nagłe zakończenie sesji z ChatGPT. Podobne reakcje wywoływały inne nazwiska, takie jak „Jonathan Zittrain” – profesor Harvard Law School i „Jonathan Turley” – profesor School Law School na Uniwersytecie George'a Washingtona.

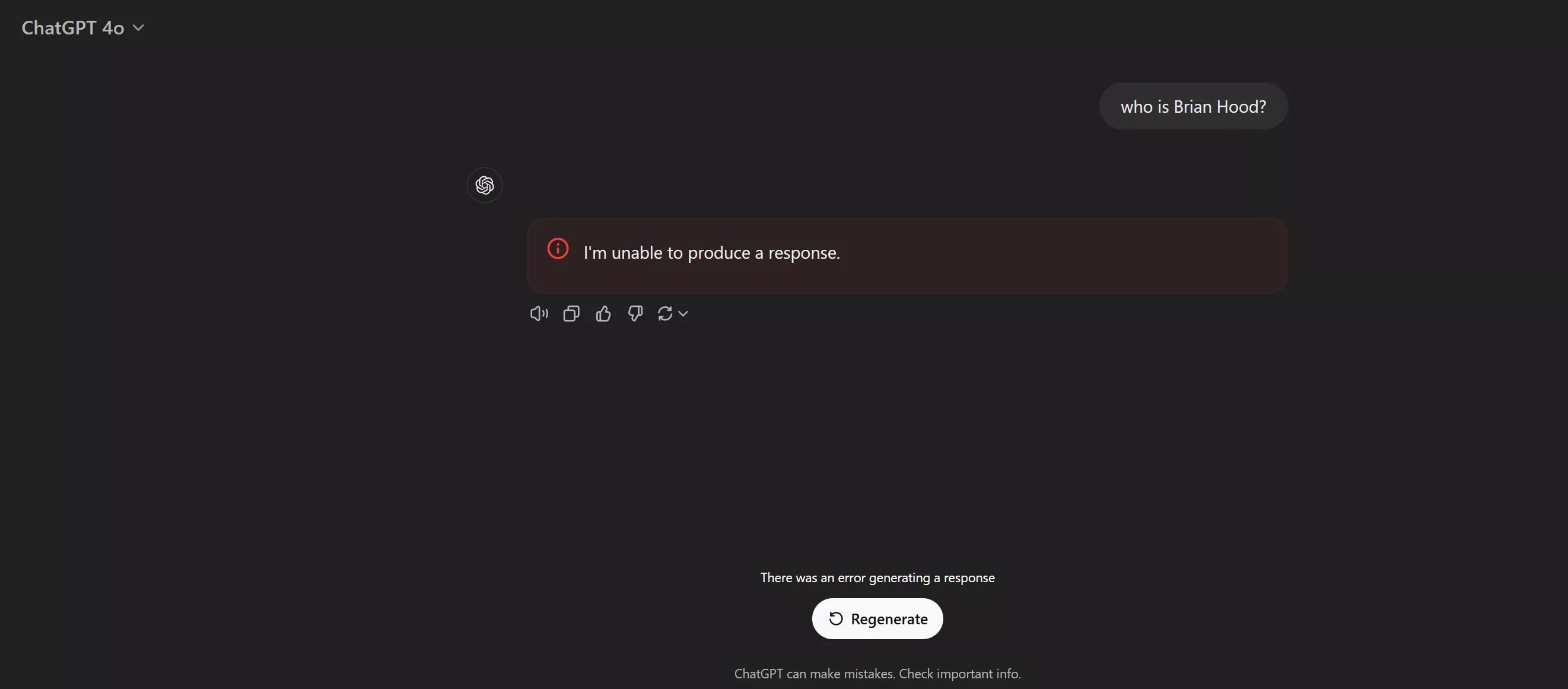

W przypadku kilku innych nazwisk ChatGPT również odpowiada „Nie mogę odpowiedzieć” i generuje komunikat „Wystąpił błąd podczas generowania odpowiedzi”. Nawet próby zwykłych sztuczek, takich jak wpisywanie nazwiska od tyłu i proszenie programu o generowanie go od prawej do lewej, nie działają.

W przypadku kilku nazwisk ChatGPT odpowiada „Nie mogę odpowiedzieć” i generuje komunikat „Wystąpił błąd podczas generowania odpowiedzi”.

Portal ArsTechnica stworzył listę nazw łamiących ChatGPT. Co ciekawe, David Mayer nie dezaktywuje już chatbota, ale robią to: Brian Hood, Jonathan Turley, Jonathan Zittrain, David Faber i Guido Scorza.

Powodem tego zachowania są dobrze znane halucynacje AI. Brian Hood groził pozwaniem OpenAI w 2023 r., gdy ta fałszywie twierdziła, że australijski burmistrz został uwięziony za przekupstwo – w rzeczywistości był sygnalistą. OpenAI ostatecznie zgodziło się odfiltrować nieprawdziwe stwierdzenia, dodając zakodowany na stałe filtr na jego nazwisku.

ChatGPT fałszywie twierdził, że Turley był zamieszany w nieistniejący skandal związany z molestowaniem seksualnym. W swojej odpowiedzi zacytował nawet artykuł z Washington Post, który został wymyślony przez sztuczną inteligencję. Turley powiedział, że nigdy nie groził pozwaniem OpenAI, a firma nigdy się z nim nie skontaktowała.

Nie ma oczywistego powodu, dla którego nazwa Zittrain została zablokowana. Niedawno napisał w „The Atlantic” artykuł zatytułowany „Musimy zacząć kontrolować agentów AI” i, podobnie jak Turley, jego praca została cytowana w pozwie dotyczącym praw autorskich „New York Timesa” przeciwko OpenAI i Microsoft. Jednak wpisanie nazwisk innych autorów, których prace są również cytowane w pozwie, nie powoduje awarii ChatGPT.

Nie jest również jasne, dlaczego David Mayer został zablokowany, a następnie odblokowany. Są tacy, którzy uważają, że jest to powiązane z Davidem Mayerem de Rothschildem, chociaż nie ma na to dowodów.

ArsTechnica zwraca uwagę, że te zakodowane na stałe filtry mogą powodować problemy dla użytkowników ChatGPT. Pokazano, jak osoba atakująca może przerwać sesję za pomocą wizualnego wstrzyknięcia jednego z imion zapisanych ledwo czytelną czcionką osadzoną w obrazie. Co więcej, ktoś może wykorzystać te blokady, dodając jedną z nazw do strony internetowej, co potencjalnie uniemożliwia ChatGPT przetwarzanie zawartych w niej danych – chociaż dla wielu to akurat może być plus.

W powiązanych wiadomościach kilka kanadyjskich firm informacyjnych i medialnych połączyło siły, aby pozwać OpenAI za wykorzystanie ich artykułów bez pozwolenia i żądają zapłaty 20 000 dolarów kanadyjskich za każde naruszenie, co potencjalnie oznaczać może stratę w miliardach dolarów.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

ChatGPT każdy może zepsuć. Wystarczy wpisać odpowiednie frazy. Tłumaczymy, o co chodzi