Amerykański startup Cerebras Systems rzuca wyzwanie gigantowi rynku procesorów graficznych, firmie Nvidia, wprowadzając innowacyjną technologię, która może zrewolucjonizować sposób, w jaki wykonywane są zadania związane ze sztuczną inteligencją.

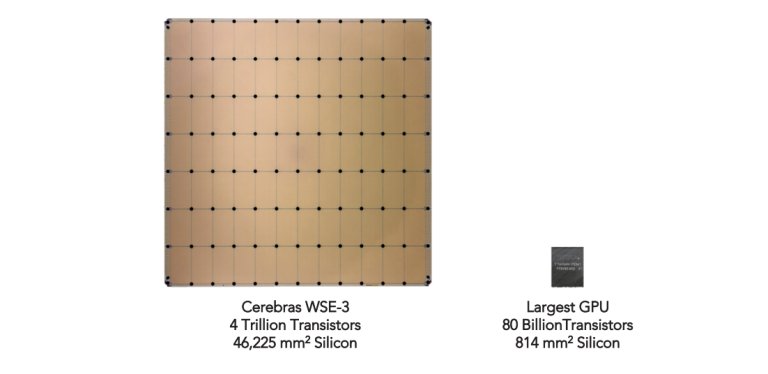

Startup rozwija procesory o nazwie Wafer Scale Engine, które mają rozmiar porównywalny do iPada. We wtorek Cerebras ogłosił nową usługę, która umożliwi klientom korzystanie z tych zaawansowanych chipów w swoich programach AI, obiecując jednocześnie znaczące przyspieszenie działania i obniżenie kosztów w porównaniu do obecnych rozwiązań oferowanych przez Nvidia. Nowa usługa, nazwana Cerebras Inference, skierowana jest na optymalizację zdolności programów AI do generowania nowych danych, jak np. przewidywanie kolejnych słów podczas pisania tekstu. Cerebras twierdzi, że ich platforma to „najszybsze rozwiązanie AI do wnioskowania na świecie”. Aby potwierdzić swoje twierdzenia, startup używa Wafer Scale Engine do obsługi najnowszego modelu dużego języka Llama 3.1 firmy Meta. Dzięki tej technologii, Llama 3.1 jest w stanie udzielać odpowiedzi praktycznie bez żadnych opóźnień.

Cerebras Systems chce rzucić wyzwanie firmie Nvidia, wykorzystując własne procesory, które, jak twierdzi, będą obsługiwać zadania związane ze sztuczną inteligencją szybciej i znacznie taniej.

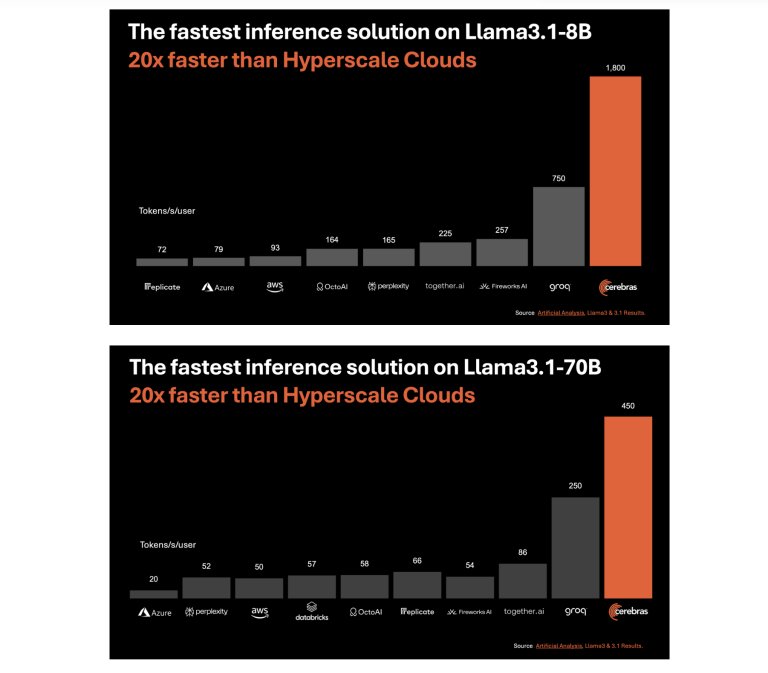

Cerebras podkreśla, że ich układy mogą obsługiwać Llama 3.1 w wersji z 8 miliardami parametrów, generując 1800 tokenów na sekundę. Przekłada się to na zdolność wygenerowania artykułu o długości 1300 słów w zaledwie sekundę. Dodatkowo, bardziej zaawansowana wersja Llama 3.1 z 70 miliardami parametrów może produkować 450 tokenów na sekundę. W obu przypadkach Cerebras twierdzi, że ich technologia znacznie przewyższa wydajność innych dostawców chmurowych, takich jak Amazon AWS, Microsoft Azure i Groq.

Jednym z kluczowych atutów Cerebras Inference jest konkurencyjna cena. Startup twierdzi, że ich usługa kosztuje znacznie mniej niż rozwiązania oparte na GPU, oferując dostęp „pay-as-you-go” za 10 centów za milion tokenów dla Llama 3.1 8B i 60 centów dla Llama 3.1 70B. Dla porównania, OpenAI, twórca ChatGPT, pobiera od firm od 2,50 do 15 dolarów za milion tokenów, co stawia Cerebras w bardzo korzystnej pozycji cenowej.

Cerebras buduje swoje układy Wafer Scale Engine we współpracy z tajwańskim TSMC, tym samym producentem, który dostarcza chipy dla Nvidia. W marcu tego roku Cerebras wprowadził trzecią generację układów, WSE-3, które posiadają 4 biliony tranzystorów oraz 900 000 rdzeni AI. Startup twierdzi, że ich chipy oferują 7000 razy większą przepustowość pamięci niż H100 od Nvidia, co eliminuje wąskie gardła i pozwala na przechowywanie całego modelu na jednym chipie.

Mimo imponujących możliwości WSE-3, Cerebras porównuje swoje rozwiązanie ze starszą technologią Nvidii. H100, który zadebiutował w 2022 roku, już wkrótce zostanie zastąpiony nową generacją układów w architekturze Blackwell. Nvidia obiecuje, że nowe GPU będą oferować nawet 30-krotną poprawę wydajności, jednak ich premiera może zostać opóźniona.

Pomimo ogromnych ambicji, Cerebras nadal ma przed sobą wyzwania. Ich układy WSE-3, choć niezwykle wydajne, są również kosztowne – pojedynczy system CS-3 kosztuje „kilka milionów dolarów”, co znacznie przewyższa cenę pojedynczego GPU H100 od Nvidia, który można nabyć za około 30 000 dolarów. Cerebras jednak planuje rozszerzyć dostępność swoich układów, oferując je także innym dostawcom usług chmurowych, co może stanowić kolejny krok w walce o rynek sztucznej inteligencji.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Chip wielkości iPada, który wygrywa z Nvidią. Startup Cerebras rzuca wyzwanie...