Meta ogłosiła właśnie szereg aktualizacji dla swoich inteligentnych okularów Ray-Ban Meta, które znacząco zwiększają funkcjonalność urządzenia.

Nowe funkcje obejmują globalne wprowadzenie tłumaczeń w czasie rzeczywistym, rozszerzenie asystenta Meta AI o funkcję wizualnego rozpoznawania kontekstu, nowe opcje stylistyczne, a także jeszcze głębszą integrację z popularnymi aplikacjami komunikacyjnymi i muzycznymi. Co więcej, ekspansja na kolejne rynki światowe ma sprawić, że okulary staną się dostępne dla znacznie szerszego grona użytkowników.

Tłumaczenie na żywo dostępne dla wszystkich

Jedną z najważniejszych nowości jest długo oczekiwana funkcja tłumaczenia na żywo, która wcześniej była zarezerwowana wyłącznie dla wybranej grupy użytkowników testowych. Teraz wszystkie osoby posiadające okulary Ray-Ban Meta mogą skorzystać z tłumaczeń w czasie rzeczywistym w językach: angielskim, francuskim, włoskim i hiszpańskim.

To ogromne udogodnienie dla podróżników i każdego, kto porusza się w wielojęzycznym środowisku. Co istotne – funkcja może działać także offline, jeśli wcześniej zostaną pobrane odpowiednie pakiety językowe. Użytkownik może więc usłyszeć natychmiastowe tłumaczenie wypowiedzi rozmówcy bez konieczności wyciągania telefonu.

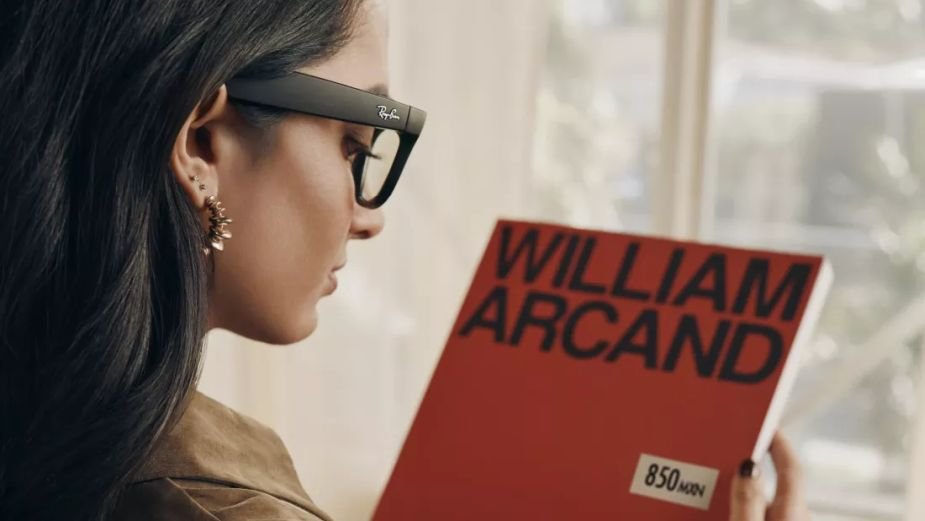

Styl spotyka technologię – nowe oprawki i soczewki

Meta nie zapomina również o modowym aspekcie swoich okularów. W najnowszej aktualizacji do kolekcji oprawek Skyler dodano nowe kombinacje kolorystyczne. Użytkownicy mogą teraz wybierać między lśniącą kredowoszarą oprawką z szafirowymi soczewkami fotochromowymi, a klasyczną czernią z przezroczystymi lub zielonymi szkłami.

To krok w stronę jeszcze większej personalizacji i dowód na to, że inteligentne okulary nie muszą rezygnować z elegancji na rzecz technologii.

Meta AI zyskuje oczy – sztuczna inteligencja analizuje obraz z kamery

Kolejnym dużym krokiem naprzód jest wprowadzenie zaawansowanych funkcji asystenta Meta AI, który teraz potrafi „widzieć to, co widzi użytkownik” dzięki stałemu dostępowi do kamery okularów.

Na razie funkcja dostępna jest w Stanach Zjednoczonych i Kanadzie, ale planowane jest jej rozszerzenie na kolejne regiony. Dzięki tej innowacji użytkownik może zadać pytanie w naturalnym języku, a AI — analizując otoczenie — udzieli kontekstowej odpowiedzi. Czy to identyfikacja zabytków, tłumaczenie menu w obcym języku, czy sugestie kulinarne na podstawie oglądanego dania – Meta AI przestaje być tylko asystentem głosowym, a staje się cyfrowym partnerem o wzroku i słuchu.

Komunikacja i muzyka: teraz jeszcze łatwiej

Wraz z aktualizacją, inteligentne okulary zyskują nowe możliwości komunikacyjne. Użytkownicy będą mogli wysyłać i odbierać wiadomości, zdjęcia oraz połączenia audio i wideo przez Instagrama – dołączając do już dostępnych integracji z WhatsAppem, Messengerem i aplikacjami natywnymi.

Miłośnicy muzyki również mają powody do zadowolenia – obsługa usług streamingowych takich jak Spotify, Apple Music, Amazon Music i Shazam została rozszerzona poza Amerykę Północną. W regionach, w których domyślnym językiem użytkownika jest angielski, możliwe jest teraz sterowanie muzyką oraz rozpoznawanie i sprawdzanie informacji o aktualnie odtwarzanym utworze – bez konieczności sięgania po smartfon.

Ekspansja globalna trwa – kolejne rynki na celowniku

Meta oficjalnie zapowiedziała wejście z inteligentnymi okularami na nowe rynki: Meksyk, Indie i Zjednoczone Emiraty Arabskie. Choć konkretne daty premiery nie zostały jeszcze ujawnione, firma podkreśla, że międzynarodowy rozwój platformy jest dla niej jednym z priorytetów.

Ważną informacją jest również to, że użytkownicy z Unii Europejskiej wkrótce uzyskają dostęp do Meta AI i jego funkcji wizualnych, co dotychczas było zarezerwowane dla Ameryki Północnej.

Pokaż / Dodaj komentarze do: Meta rozwija inteligentne okulary Ray-Ban. W tle tłumaczenia na żywo, nowe style i integracja z AI