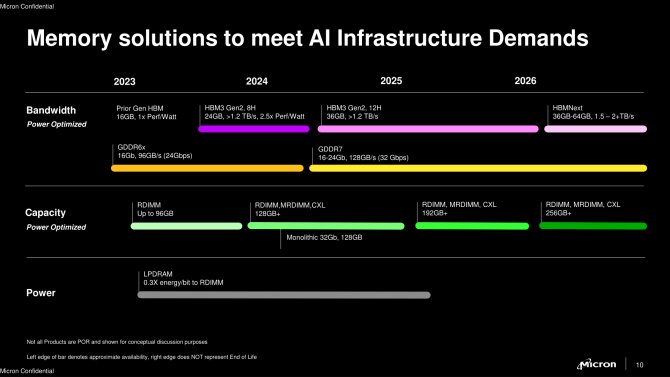

Firma Micron ogłosiła wprowadzenie na rynek swojej najnowszej pamięci o dużej przepustowości (HBM), prezentując drugą generację HBM3e.

To najnowsze osiągnięcie w dziedzinie pamięci dla zaawansowanych systemów obliczeniowych oferuje rekordową pojemność 36 GB na moduł. W porównaniu z poprzednią wersją HBM3, która miała 24 GB, nowa wersja zapewnia o 50% większą pojemność. Osiągnięcie tego wyniku było możliwe dzięki zwiększeniu liczby ułożonych pionowo chipów z ośmiu do dwunastu.Micron poinformował, że jego nowa pamięć HBM3e jest już gotowa do produkcji i wysyłana do partnerów z branży sztucznej inteligencji. Wśród tych partnerów wymienia się m.in. gigantów takich jak Nvidia, którzy prawdopodobnie wykorzystają nową pamięć w przyszłych akceleratorach AI.

Nowa pamięć jest udoskonaloną wersją poprzednich ośmiowarstwowych modułów o pojemności 24 GB.

Według Microna, ich technologia przewyższa konkurencję pod względem wydajności energetycznej – zużycie energii zostało zmniejszone o 30% w porównaniu z ośmiowarstwowymi modułami HBM3 oferowanymi przez konkurencję. Przypuszcza się, że tą wspomnianą konkurencją może być Samsung, chociaż w grę wchodzi także SK Hynix. Micron zaznacza, że jego nowa technologia HBM3e zapewnia lepszą wydajność na wat o ponad 2,5 W.

Zastosowanie w nadchodzących akceleratorach AI

Zapotrzebowanie na pamięci HBM3e w branży AI rośnie w oszałamiającym tempie, a nowa technologia Microna może znaleźć zastosowanie w nadchodzących produktach największych graczy na rynku. Przykładem jest Nvidia, której akcelerator Blackwell B200 ma wykorzystywać 24 GB pamięci HBM na stos. Dzięki nowej ofercie Micron, Nvidia może w przyszłości zdecydować się na wprowadzenie ulepszonej wersji tego procesora graficznego, wykorzystując większą pojemność HBM3e.

Podobne kroki podejmuje także AMD, które zamierza zaktualizować swoją linię akceleratorów MI300 do obsługi HBM3e. AMD już wcześniej zadebiutowało na rynku z pamięcią HBM3, a teraz planuje przejść na nowszą wersję, co pozwoli na jeszcze bardziej zaawansowane możliwości w zakresie obliczeń AI.

Wyścig na rynku pamięci HBM3e

W ciągu ostatnich miesięcy firmy Samsung i Micron ogłosiły swoje plany związane z 12-warstwowymi modułami HBM3e, a wyścig o dostarczenie najlepszych rozwiązań trwa. Jednak już teraz widać, że zapotrzebowanie na pamięci HBM przekracza możliwości produkcyjne. Zarówno Micron, jak i SK Hynix poinformowali, że cała produkcja pamięci HBM na 2024 i większość 2025 roku została już wyprzedana. W obliczu tego boomu na technologie AI, wyścig o większą przepustowość i pojemność pamięci będzie się jedynie nasilał.

HBM4 na horyzoncie

Chociaż obecna technologia HBM3e stanowi znaczący krok naprzód, prawdziwy przełom w wydajności pamięci ma nastąpić wraz z premierą HBM4, która jest zaplanowana na 2026 rok. Do tego czasu, jak pokazuje harmonogram Microna, 12-warstwowy HBM3e będzie dominującym wyborem dla rozwiązań sztucznej inteligencji.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Micron wpowadza 12-warstwową pamięć HBM3e o pojemności 36 GB