Stosowanie algorytmów predykcyjnych do wskazywania opiece społecznej może dla niektórych być kontrowersyjne, jednak pracownicy socjalni w USA korzystają z systemów sztucznej inteligencji przy podejmowaniu decyzji, czy wszcząć dochodzenie w sprawie zaniedbywania dzieci przez rodziców.

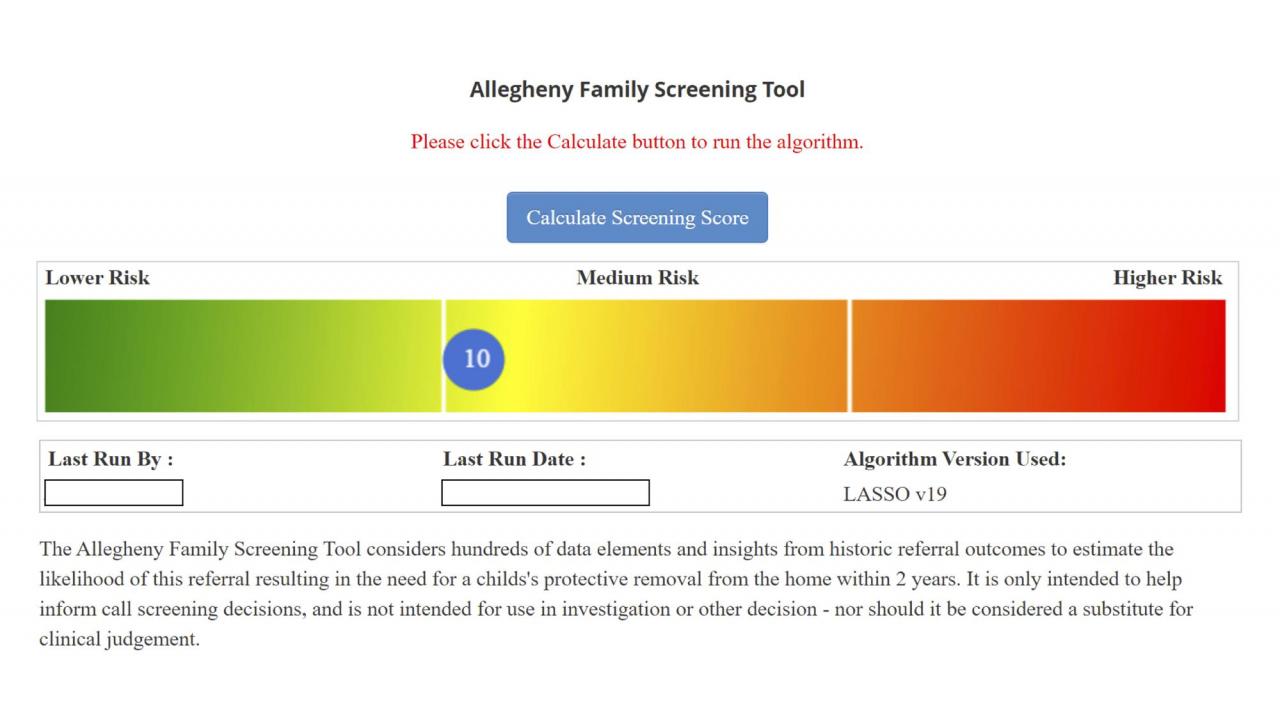

Algorytm, który coraz szerzej wykorzystywany jest w USA, dostarcza pracownikom socjalnym obliczeń statystycznych, na których mogą opierać swoje działania. Agencja AP opisuje go jednak jako nieprzejrzysty. Uniwersytet Carnegie Mellon podnosi również obawy o niezawodność algorytmów (co powinno być oczywiste), a także wywoływania "pogłębienia różnic rasowych w systemie opieki nad dziećmi". W badaniu uniwersyteckim, które dotyczyło hrabstwa Allegheny, stwierdzono, że pracownicy socjalni nie zgadzają się z co trzecią oceną ryzyka, jaką uzyskuje system, podczas gdy w innym badaniu stwierdzono, że liczba czarnych dzieci, w stosunku do których wszczęto obowiązkowe dochodzenie w sprawie zaniedbania, jest "nieproporcjonalnie duża" w porównaniu z ich białymi rówieśnikami, i że przejawia się to jako wzór. Naukowcy z CMU odkryli, że od sierpnia 2016 r. do maja 2018 r. narzędzie obliczyło wyniki, które sugerowały, że 32,5% czarnoskórych dzieci zgłoszonych jako zaniedbywane powinno podlegać „obowiązkowemu” dochodzeniu, w porównaniu z 20,8% białych dzieci.

Algorytmy predykcyjne stosowane przez opiekę społeczną w USA są oskarżane o "pogłębianie różnic rasowych w systemie opieki nad dziećmi". System wskazał, że 32,5% czarnoskórych dzieci zgłoszonych jako zaniedbywane powinno podlegać „obowiązkowemu” dochodzeniu, w porównaniu z 20,8% białych dzieci. Algorytm nie bierze rasy jako zmiennej w przewidywaniach.

Hrabstwo nie zakwestionowało danych naukowców CMU, ale Erin Dalton, dyrektor Departamentu Usług Społecznych hrabstwa i pionier we wdrażaniu algorytmu, powiedziała, że artykuł badawczy przedstawia „hipotetyczny scenariusz, który jest całkowicie oderwany od sposobu, w jaki to narzędzie zostało wdrożone w celu wsparcia naszej siły roboczej”, twierdząc jednocześnie, że pracownicy socjalni mają ostatnie słowo w podejmowaniu decyzji, niezależnie od wyników uzyskanych za pomocą tego narzędzia.

„Kiedy masz technologię zaprojektowaną przez ludzi, w algorytmach pojawi się stronniczość” – powiedział Nico'Lee Biddle, który przez prawie dziesięć lat pracował w opiece nad dziećmi, w tym jako terapeuta rodzinny i specjalista ds. umieszczania w opiece zastępczej w Allegheny. „Jeśli zaprojektowali doskonałe narzędzie, to naprawdę nie ma znaczenia, ponieważ zostało zaprojektowane z bardzo niedoskonałych systemów danych”.

Hrabstwo początkowo rozważało uwzględnienie rasy jako zmiennej w swoich przewidywaniach dotyczących względnego ryzyka rodziny, ale ostatecznie zdecydowało się tego nie robić, zgodnie z dokumentem z 2017 roku. Krytycy twierdzą, że nawet jeśli rasa nie jest mierzona wprost, dane z programów rządowych wykorzystywanych przez wiele kolorowych społeczności mogą być wskaźnikiem rasy. W dokumencie sami twórcy wezwali do dalszego monitorowania „w odniesieniu do różnic rasowych”.

Na razie formy zaniedbania, które są badane przy pomocy narzędzia algorytmicznego, to jakość warunków mieszkaniowych i higiena dziecka, ale nie nadużycia seksualne i inne formy przemocy fizycznej. Biorąc pod uwagę rodzaj kwestii, które są badane w celu podjęcia decyzji o wszczęciu dochodzenia, nie jest zaskakujące, że większość zebranych danych dotyczy rodzin ubogich.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Predykcyjne algorytmy AI opieki społecznej oskarżane są o rasizm