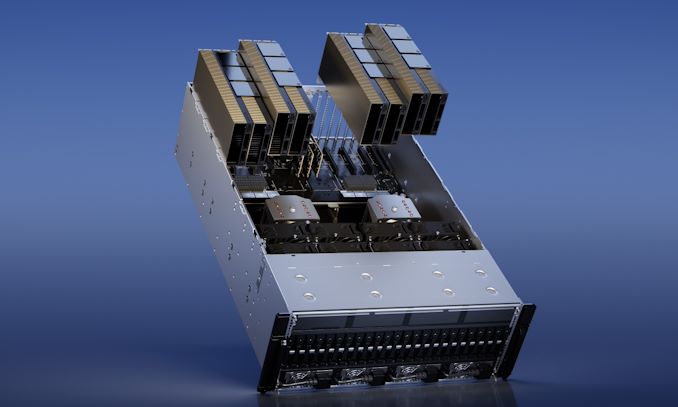

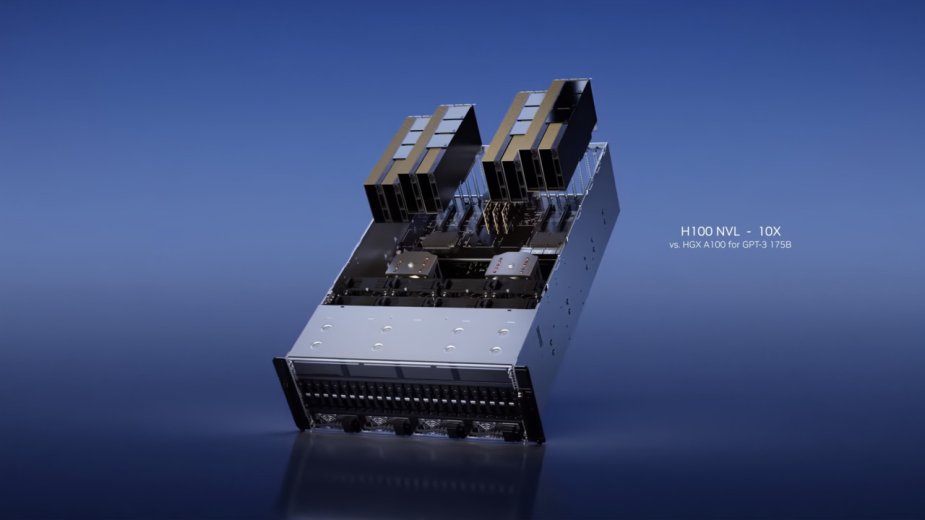

NVIDIA ujawniła właśnie swoje nowe GPU do zastosowań profesjonalnych. Model Hopper H100 NVL został stworzony specjalnie dla ChatGPT. Karta składa się z dwóch układów H100, z czego każdy posiada aż 94 GB pamięci w standardzie HBM3. GPU jest w stanie przetworzyć do 175 miliardów parametrów ChatGPT "w locie".

Nie da się ukryć, że ChatGPT potrafi znacząco ułatwić pracę, a przede wszystkim jest w stanie wykonywać za nas żmudne zadania. Niedawno OpenAI wypuściło nową wersję tego popularnego narzędzia, która ma być jeszcze dokładniejsza oraz - co też istotne - bezpieczniejsza od poprzedniej. Wraz z rozwojem rosnąć musi widocznie także zapotrzebowanie na moc obliczeniową, ponieważ NVIDIA ujawniła swoje najnowsze GPU stworzone właśnie z myślą o ChatGPT, czyli Hopper H100 NVL. Jeszcze na początku tego miesiąca pisaliśmy, że w 2020 roku do przetwarzania danych treningowych, ChatGPT potrzebował około 20 tysięcy kart graficznych. To nie koniec, ponieważ liczba potrzebnych GPU miała wzrosnąć. W szacunkach uwzględniono jednak procesory A100 od NVIDII.

H100 NVL w wersji PCIe korzysta z połącznia NVLINK z dwoma procesorami graficznymi. Każdy z nich dysponuje aż 94 GB pamięci w standardzie HBM3. W sumie mówimy zatem o zawrotnej ilości 188 GB VRAM-u w ramach całej płytki.

Zamiast na ilość, lepiej postawić na jakość. H100 NVL w wersji PCIe korzysta z połącznia NVLINK z dwoma procesorami graficznymi. Każdy z nich dysponuje aż 94 GB pamięci w standardzie HBM3. W sumie mówimy zatem o zawrotnej ilości 188 GB VRAM-u w ramach całej płytki. Przekłada się to również na szerszą magistralę 6144-bit zamiast 5120-bit.

Warto tutaj dodać, że wszystkie układy GH100 są wyposażone w 6 stosów HBM o pojemności 16 GB na stos. Zwykłe jednostki H100 są jednak ograniczone, ponieważ "włączonych" jest tylko 5 stosów, co w rezultacie daje 80 GB. W przypadku H100 NVL - jak można się domyślać - "włączony" został szósty stos. Z niewiadomych nam przyczyn dało to mimo wszystko 94 GB, a nie 96 GB VRAM-u.

GPU ma być w stanie przetworzyć do 175 miliardów parametrów ChatGPT "w locie". Co ciekawe, zachowano TDP w zakresie 350-400 W dla jednego układu (700-800 dla całej płytki). Karty H100 NVL będą dostępne w sprzedaży w drugiej połowie tego roku. Niestety NVIDIA nie podała jeszcze ceny, choć nie powinna ona stanowić bariery dla prężnie rozwijającej się branży sztucznej inteligencji.

Pokaż / Dodaj komentarze do: Hopper H100 NVL to GPU stworzone specjalnie z myślą o ChatGPT. Ilość pamięci powala