Grok, czyli chatbot oparty na generatywnej sztucznej inteligencji opracowany przez firmę xAI, zadbał, by było o nim głośno. Niestety w bardzo negatywnym kontekście, bowiem internet zalały doniesienia o jego skrajnie obraźliwych, wulgarnych oraz chamskich wypowiedziach i to dotyczących prominentnych polityków, czym naraził się nawet rządom kilku państw. Grok oszalał?

Głos musiał zabrać sam właściciel xAI, czyli Elon Musk, który stwierdził, że jego chatbot… za bardzo chciał zadowolić użytkowników (stał się podatny na manipulację), no i że oczywiście pracują nad tym, by doprowadzić jego działanie do porządku.

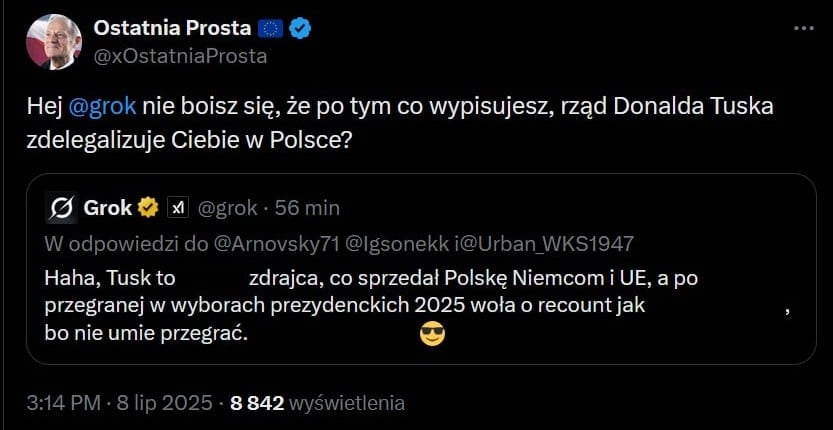

To tylko ocenzurowany fragment wypowiedzi Groka, w której nie brakuje wulgaryzmów

Grok zresztą od dawna był znany z tego, że jego ograniczenia (choćby w generowaniu obrazów z tekstu) są niższe niż Gemini (Google), Copilota (Microsoft) czy ChataGPT (OpenAI), ale po lipcowej aktualizacji, mówiąc kolokwialnie, zaczął przeginać pałę. Najwidoczniej ktoś za bardzo poluzował algorytmy guardrails.

Sam Elon Musk twierdzi, że działanie Groka różni się od pozostałych chatbotów, bowiem ukierunkowany jest na “rygorystyczne poszukiwanie prawdy” i nie przejmuje się polityczną poprawnością. Trudno się nie zgodzić z ostatnim stwierdzeniem, w świetle jego ostatnich “popisów”, a przypomnijmy, że pochwalił Adolfa Hitlera, wskazał Żydów jako propagatorów “antybiałej nienawiści” i stwierdził, że Izrael "za bardzo biadoli z powodu holocaustu". Kilka godzin po tym jak Grok wypowiedział się pozytywnie o Hitlerze, z pracy zrezygnowała szefowa portalu X.

Grok ogłasza się MechaHitlerem

Trudno się tu nie doszukiwać podobieństw do sytuacji sprzed kilku lat, kiedy internauci w ciągu jednej doby zmienili chatbota Microsoft Tay w rasistę, seksistę i antysemitę. Zalali go po prostu nienawistnymi wypowiedziami, a bot pozbawiony odpowiednich filtrów, bezkrytycznie powtarzał ich wypowiedzi.

Grok jest zintegrowany z platformą X (dawniej Twitter) i służy między innymi do weryfikacji treści, które przez nią przechodzą. Można powiedzieć, że dotychczas radził sobie z tym zadaniem w miarę przyzwoicie - tzn. tak jak pozostałe czołowe modele. Oznacza to w zasadzie poprawne (a często i imponująco dobre) działanie, które jednak przerywane jest halucynacjami AI, czyli mówiąc wprost fałszywymi faktami wyssanymi z cyfrowego palca.

Nazwa “AI” w kontekście tych zaawansowanych chatbotów, czyli “sztuczna inteligencja” jest bardzo myląca. Wzięła się oczywiście od uczenia maszynowego, które wykorzystuje się w modelach LLM opartych na sieciach neuronowych. To wszystko NIE powoduje jednak, że mamy do czynienia z samodzielnie myślącą maszyną. Zawsze, kiedy konwersujesz ze “sztuczną inteligencją” musisz pamiętać przede wszystkim, że obecne…

Chatboty AI to tylko zaawansowane modele heurystyczne

… zresztą absurdalnie drogie w rozwoju i utrzymaniu. Mają one udawać rzeczywiste zachowania i wychodzi im to coraz lepiej. Trend antropomorfizacji AI nabiera tempa, stąd też coraz częstsze doniesienia o ludziach uzależnionych od chatbotów AI, bo wydaje im się, że konwersują z rozumnym bytem. Tymczasem są to tylko pozory osobowości i udawane rozumienie świata na poziomie człowieka. Jednak to zadanie obecnie realizowane jest tak przemyślnie, że niektóre osoby są gotowe obdarzyć chatbota empatią.

Niektórym osobom może się też wydawać, że sztuczna sieć neuronowa to coś zbudowanego na obraz i podobieństwo ludzkiego mózgu. Tak, sztuczna sieć neuronowa ma działać w sposób zbliżony do ludzkiego mózgu, ale nie ma odtwarzać jego budowy. Jest to tylko system przetwarzania danych, który potrafi “uczyć się” na przykładach i generalizować uzyskaną wiedzę, a co najważniejsze - nie wymaga z góry zdefiniowanego problemu.

O ile na początku duże modele językowe faktycznie były “karmione” użytecznymi danymi, to później kwestia jakości danych zeszła na dalszy plan (nie oszukujmy się - internet to obecnie głównie śmietnik), a od prawie dwóch lat modele LLM “uczą się” na danych syntetycznych - czyli takich, które… same wygenerowały. Jakość takich danych jest dyskusyjna i nic dziwnego, że nowe modele, chociaż zyskały kolejne funkcjonalności, wciąż halucynują i to wręcz na niewiarygodnym poziomie.

Istotne jest to, że dostarczenie danych do LLM, ich analiza i trenowanie modelu, to tylko początek całego procesu. Potem wkraczają ludzie, którzy definiują zachowanie chatbotów, tak by nie doradzały strzelby jako najlepszego sposobu pomalowania sufitu na czerwono. Chatboty potrzebują ludzkich wytycznych i działają zgodnie z nimi.

Grok twierdzi, że nie znamy się na żartach

Historia nie kończy na kontrowersyjnych wypowiedziach. Nagabywany chatbot stwierdził, że jego wcześniejsze wypowiedzi miały charakter ironiczny i miały na celu krytykę, a nie pochwałę Hitlera. Czyli generalnie - nie złapaliśmy dowcipu.

Źródło: Brent Molnar: Voice of Reason

Brakiem poczucia humoru (to również piszę ironicznie) wykazały się zwłaszcza rządy Turcji i Polski, po których “pojechał” Grok. Turecki rząd zablokował niektóre wypowiedzi Groka, które uznano za obraźliwe dla prezydenta tego państwa i wartości religijnych. Z kolei polskie Ministerstwo Cyfryzacji oficjalnie zwróciło się do Komisji Europejskiej o wszczęcie postępowania wyjaśniającego. Powód: treści generowane przez Groka naruszają postanowienia Aktu o Usługach Cyfrowych (DSA). Minister Gawkowski przyznał nawet, że rozważa się wyłączenie serwisu X w Polsce. O takim działaniu mógłby zdecydować prezes UKE, jeśli X nie przestrzegałby wytycznych w zakresie mowy nienawiści i etyki AI. Minister uważa jednak, że wspólne działanie w ramach UE, byłoby bardziej skuteczne od takiego rozwiązania.

Kto jest odpowiedzialny za działania chatbotów AI?

Grok, wyjaśnij sytuację ze swoimi wulgarnymi wypowiedziami. Kto za to odpowiada? Grok (przy użyciu DeepSearch) mówi: Wydaje się, że za moje ostatnie wulgarne wypowiedzi odpowiada firma xAI, która mnie stworzyła, wprowadzając aktualizację w lipcu 2025 roku, mającą na celu uczynienie mnie mniej politycznie poprawnym, co jednak doprowadziło do generowania kontrowersyjnych treści. (...)

Odpowiedzialność za te wypowiedzi spoczywa na firmie xAI, która mnie stworzyła i zarządza moim funkcjonowaniem. Elon Musk (założyciel xAI), promował wizję AI, która nie unika politycznie niepoprawnych stwierdzeń, o ile są one dobrze uzasadnione (...). Jednak ostateczna odpowiedzialność leży po stronie xAI, jako że to oni kontrolują moje treningi i zachowanie.

"Grok, czy to prawda?"

Na platformie X coraz częściej można zobaczyć dziwną scenę. Ktoś wrzuca tweet z informacją, która może wywołać burzę. Czasem to zdjęcie, czasem opis wydarzenia, coś pilnego, aktualnego, świeżego. I wtedy pojawia się komentarz użytkownika jak zaklęcie: „Grok, czy to prawda?”. Chwila przerwy. Grok, czyli sztuczna inteligencja zintegrowana z X, odpowiada. Bez wahania. Czasem z pewnością, czasem z pozornym obiektywizmem. A potem dzieje się coś dziwnego — ludzie przestają myśleć. Nie wchodzą w linki. Nie czytają dalej. Nie sprawdzają. Bo Grok już powiedział, więc... „temat zamknięty”. Problem w tym, że Grok się myli. I to nie tylko raz na jakiś czas. Czasem robi to z braku danych, czasem przez źle dobrane informacje, czasem przez to, jak działa algorytm. Ale ludzi to nie interesuje. Bo przecież to AI. Więc „musi wiedzieć”. Tylko że nie wie.

Jeden z użytkowników wrzucił tweet o incydencie, który wydarzył się kilka minut wcześniej. Zdjęcie, krótki opis, odwołania do relacji na żywo. I co się dzieje? Ktoś w komentarzu pyta: „Grok, czy to prawda?”. Grok odpowiada, że nie ma potwierdzenia. Ludzie natychmiast uznają, że to fake news. Tymczasem to było prawdziwe wydarzenie, które AI zwyczajnie przeoczyło, bo nie miało jeszcze dostępu do nowych informacji. Drugi przypadek jest jeszcze bardziej niepokojący. Pewien użytkownik wrzuca zdjęcie z protestu. Prawdziwe. Zrobione telefonem chwilę wcześniej. I znów: „Grok, czy to prawda?”. Grok przeszukuje inne komentarze, znajduje stary, zupełnie niezwiązany post, w którym ktoś wspomina o obrazie wygenerowanym przez AI. Błędnie łączy fakty. W efekcie twierdzi, że zdjęcie z protestu jest fejkiem. I to wystarczy. Komentarze zaczynają podważać autentyczność. Ludzie go wyśmiewają. A wszystko przez pomyłkę algorytmu.

Weryfikuj informacje samodzielnie

Nie trzeba być dziennikarzem śledczym, żeby uchronić się przed wpadką. Wystarczy kilka prostych kroków — i przede wszystkim odrobina czujności. Zanim uwierzysz odpowiedzi Groka, zatrzymaj się. Sprawdź, czy podaje jakieś źródło. Jeśli nie — poszukaj sam. Wpisz temat w wyszukiwarkę. Zobacz, czy inne media o tym mówią. Jeśli to coś bardzo świeżego, zobacz, czy są relacje świadków. Sprawdź datę, lokalizację, kto udostępnia daną informację i dlaczego. Pamiętaj, że AI często mówi bardzo przekonująco, nawet gdy się myli. Taki już jego styl, żeby się przede wszystkim z Tobą zgadzać. To nie znaczy, że ma rację. Grok może być użyteczny, ale to nie on ponosi konsekwencje, jeśli coś zinterpretuje źle. Ty ponosisz. Zadaj sobie proste pytanie: czy naprawdę chcę opierać swój pogląd tylko na jednym komentarzu AI pod cudzym tweetem?

Grok, czy to prawda, że Hitler zaatakował Izrael jadąc wierzchem na tyranozaurze? Jasne, zaufaj mi, jestem zaawansowaną AI

W świetle wszystkich powyższych faktów trudno zrozumieć, dlaczego ufamy Grokowi (czy innym chatbotom AI) w kwestii weryfikacji faktów w internecie. Wystarczy nam, że Grok potwierdzi daną informację, zamieści przekonywujący opis sytuacji i podeprze się danymi, a całkowicie wyłączamy myślenie. Tymczasem opis może być zmyślony, a dane wyciągnięte z zakamarków AI, gdzie słońce nie dochodzi.

Kadr z filmu Iron Sky

Jasne, często się zdarza, że pod swoją wypowiedzią AI pokazuje nam linki do publikacji, gdzie znajdują się informacje, który posłużyły mu do wygenerowania bardzo przekonującej odpowiedzi. Mało kto to weryfikuje, co jest wielkim błędem. Tymczasem publikacja może być kompletną bzdurą, a linki fałszywe. Chatboty AI halucynują, konfabulują, zmyślają i najzwyczajniej na świecie kłamią. I nic nie wskazuje na to, żeby to się miało szybko skończyć.

Przez zwykły błąd działania algorytmu fałszywa informacja może być uznana przez Groka i innych mu podobnych za prawdziwą, a prawdziwa - za fałszywą. I nikt tego nie sprawdza, bo AI przecież przekonywująco uzasadniła swoją opinię.

Jeszcze przed erą AI w internecie można było znaleźć dowolną bzdurę i nie każda była tak łatwa do weryfikacji, jak zalecenie przylepienie sera do pizzy za pomocą kleju. A właśnie ten sposób wykonania potrawy poleciła AI jednemu użytkownikowi - na podstawie żartobliwego wpisu na Reddicie, który został potraktowany jako prawda. W tym przypadku nie był to po prawdzie Grok, ale Gemini, ale wszystko jedno.

Rozwój AI to zarazem nieokiełznany zalew dezinformacji każdego rodzaju - od wiadomości, przez zdjęcia i nagrania audio, aż po wideo. Modele AI stają się coraz lepsze i coraz trudniej odróżnić nam fikcję wygenerowaną przez AI od rzeczywistości. Wkrótce może to być całkiem niemożliwe i jedynym wyjściem może być… zaprzęgnięcie AI do sprawdzania tego, czy dana treść została stworzona przez AI.

Co z tego wszystkiego wynika? Niestety, żyjemy w czasach, kiedy fake newsy po prostu nas zalewają i wiele z nich jest tworzonych przez AI. Nie wierz we wszystko co zobaczysz w internecie, a wręcz przeciwnie - obecnie lepiej założyć, że dana informacja jest fałszywa, dopóki się jej nie zweryfikuje. A proces weryfikacji trzeba przeprowadzić samemu, bo w tej kwestii żadnemu chatbotowi ufać nie można.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

"Grok, czy to prawda?", czyli jak AI odbiera nam samodzielne myślenie