Zagłębiając się w temat optymalizacji pracy karty graficznej, nie da się ominąć pojęć overvoltingu i undervoltingu. Są to anglojęzyczne terminy oznaczające, odpowiednio, podniesienie lub obniżenie napięcia zasilającego rdzeń. Na przestrzeni ostatnich lat, entuzjaści korzystali głównie z możliwości zwiększenia napięcia, dążąc do uzyskania jak najlepszych wyników w podkręcaniu, ale, dzięki rosnącej popularności kryptowalutowego górnictwa i specyfice kilku ostatnich grafik z obozu AMD, popularność zyskał również undervolting. Już tłumaczę, dlaczego. Dla użytkowników, szczególnie w ww. przypadkach, zaczęła liczyć się ekonomia, nie bezwzględna maksymalizacja mocy obliczeniowej, w każdym możliwym scenariuszu (choć czasem jedno i drugie idzie w parze, do czego dojdziemy). Dlatego też agresywne podkręcanie kart graficznych zostało nieco zdewaluowane, na rzecz ich bardziej ogólnie pojętej optymalizacji. Jeśli jesteście ciekawi, co takiego kryje się pod tym, może dość enigmatycznym, hasłem, to serdecznie zapraszam do kontynuowania niniejszej lektury.

Niniejszy artykuł poświęcony jest teoretycznym aspektom procesu overvoltingu i undervoltingu. Praktyczne zastosowanie manipulacji napięciem, na przykładzie Radeona RX 570, znajdziecie pod tym linkiem.

Praktyczna strona undervoltingu została już omówiona przy okazji testu Radeona RX 570 4 GB od Gigabyte / AORUS (kliknij na grafikę, aby przenieść się do stosownego materiału)

Zacznijmy od podstaw. Z wydajnością karty graficznej, pomijając parametry niemodyfikowalne jak liczba procesorów strumieniowych czy ilość pamięci, kojarzy nam się przede wszystkim częstotliwość taktowania. Jest to, z definicji, gęstość biegu impulsów w ścieżkach. Procesor graficzny (i każdy inny) wykonuje dokładnie jedną podstawową operację, wraz z dotarciem impulsu taktującego. Co prawda wielkość ta nie definiuje, ile podstawowych operacji wymaganych jest do zrealizowania pojedynczego rozkazu, przez dany chip, ale i tak znajduje jakieś odzwierciedlenie w końcowej wydajności. Stąd wielu użytkowników decyduje się na podkręcanie, czyli, najprościej ujmując, zwiększenie częstości biegu impulsów, w układzie. Teraz, im szybciej poruszają się impulsy, tym łatwiej o zakłócenia w torze ścieżki, co przekłada się na niestabilność działania. Dla przykładu, znane wszystkim artefakty graficzne są owocem zniekształconych danych, zapisanych w buforze ramki, właśnie wskutek wspomnianych zakłóceń sygnału.

Rodzi się pytanie: jak można takim zakłóceniom przeciwdziałać? Ano, i tu do gry wkracza napięcie albo, jak kto woli, różnica potencjałów, a więc stosunek pracy wykonanej przeciwko polu, w czasie przenoszenia ładunku elektrycznego. Mówiąc obrazowo, po zwiększeniu napięcia, impulsy w układzie popychane są z większą siłą, przez co skuteczniej opierają się przeszkodom na swej drodze. Wraz z napięciem rośnie jednak także opór, a nakład pracy staje się większy, intensyfikując zapotrzebowanie na energię elektryczną i, w konsekwencji, prowadząc do większych strat energetycznych. Tych ostatnich doświadczamy w formie zwiększonych temperatur, których następstwo stanowi z kolei wzrost prędkości obrotowej wentylatorów, itd. Ale na ten moment wszystko, w dalszym ciągu, wydaje się całkowicie zrozumiałe. Fakt faktem wzrost zużycia energii elektrycznej czy głośniejsza praca układu chłodzenia są czynnikami, do których zwolennicy podkręcania zdążyli przywyknąć. Coś za coś, jak to mawiają. Niemniej diabeł tkwi w szczegółach, a rzeczonym jest to, że taktowanie oraz pozostałe czynniki elektryczne nie są jakkolwiek proporcjonalne, względem siebie.

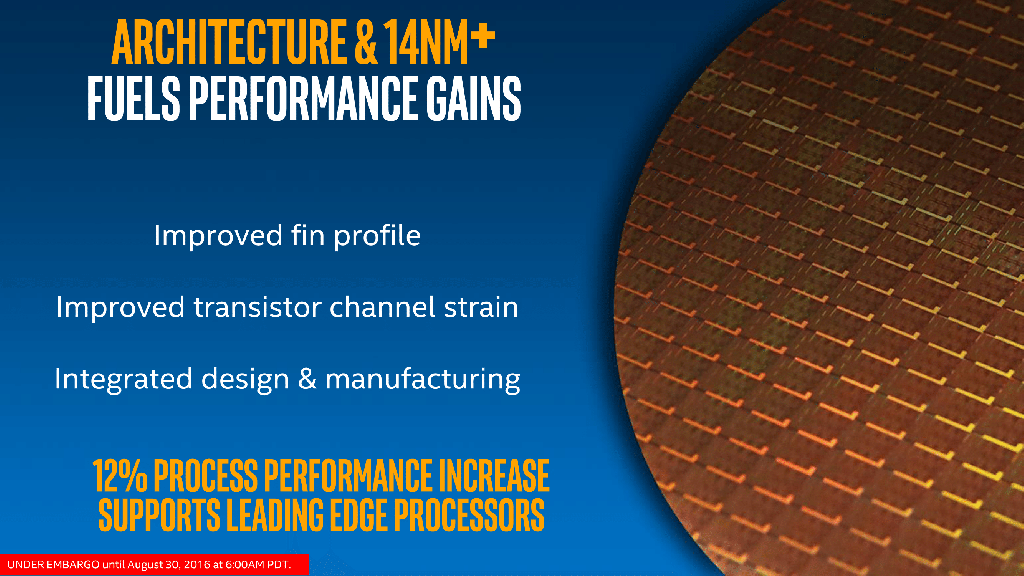

Procesy litograficzne, należące pozornie do tej samej klasy, np. 14 nm, mogą drastycznie od siebie odbiegać

Załóżmy, że istnieje karta graficzna, która przy napięciu 1,0 V ma fabryczne taktowanie 1 GHz, a, pod maksymalnym obciążeniem, wymaga 200 W energii elektrycznej. Nie jest regułą, że, po zwiększeniu napięcia do 1,1 V, stabilnie osiągniemy 1,1 GHz, natomiast watomierz wskaże 220 W, i to w każdym egzemplarzu hipotetycznego modelu. Nie będzie tak, o ile nie zadziała zbieg okoliczności, a powodów takiego stanu rzeczy jest mnóstwo. Najistotniejsze, wbrew pozorom, wynikają z samej architektury chipu. Poszczególne typy kart, nawet jeśli wykonane są w procesie technologicznym tej samej (lub zbliżonej) klasy, charakteryzują się drastycznie odmiennym upakowaniem (zagęszczeniem) tranzystorów, przez co różne są również szerokości ich bramek. Szersze bramki zapewniają większą tolerancję wysokich częstotliwości, ale też wymuszają stosowanie wyższych napięć, co doskonale obrazuje przykład procesorów Skylake oraz Kaby Lake, które są tymi samymi konstrukcjami, różniącymi się właśnie szerokością bramki. Na tej samej zasadzie akceleratory marki NVIDIA przeważnie mogą pracować szybciej od konkurentów z obozu AMD. Łatwo policzyć, na podstawie danych dostarczonych przez producentów, że GeForce GTX 1080 ma około 22,9 mln tranzystorów na 1 mm2 rdzenia, Radeon RX Vega 64 zaś - ponad 25,8 mln. Przechodząc do napięć, konstrukcja Zielonych domyślnie potrzebuje około 1,1 - 1,15 V, natomiast Czerwonych - 1,05 V. Różnicy w taktowaniach chyba tłumaczyć nie trzeba.

I tak, teoria znajduje swe odzwierciedlenie w rzeczywistości. Ale to, co oczywiste, dopiero wierzchołek góry lodowej. Moc faktycznie wylicza się ze stosunku napięcia do natężenia, ale końcowe natężenie jest w przypadku podkręcania niewiadomą. No, i nie zależy zapominać o zjawisku losowości rdzenia, występującym w obrębie tych samych modeli. Jeśli fragment krzemu, z którego wykonano dany układ, cechuje się większą czystością chemiczną, to, siłą rzeczy, uzyskamy produkt o mniejszych stratach energetycznych, bardziej odporny na zakłócenia sygnału i lepiej przyjmujący wysokie częstotliwości. Jednocześnie, powtarzam, nie istnieje tu żadna forma proporcjonalności taktowania, w odniesieniu do pozostałych czynników.

Firma Zotac otwarcie chwali się selekcjonowaniem rdzeni, pod kątem możliwości podkręcania

Jak zatem radzą sobie producenci, przy ustalaniu taktowań i napięć kolejnych kart? Otóż stosują oni swego rodzaju uśrednienie. Inżynierowie badają pewną pulę wyprodukowanych rdzeni, a następnie dobierają parametry tak, by jak najwięcej egzemplarzy mogło pracować stabilnie, przy jednoczesnym uzyskaniu możliwie wysokiej wydajności (taktowanie) oraz minimalizacji zużycia energii (napięcie). Potem swą cegiełkę dokładają jeszcze dostawcy modeli autorskich, którzy dodatkowo selekcjonują chipy, oferując, w następstwie, modele fabrycznie przyśpieszone lub bardziej energooszczędne. Nawet na tym etapie system ma swoje wady. Selekcjonowanie odbywa się mniej lub bardziej globalnie, z uwzględnieniem większej puli egzemplarzy, zdatnej do produkcji masowej, a, tak naprawdę, każdy jeden układ jest inny i niepowtarzalny. W rezultacie nad wyraz często, dobierając parametry samemu, można uzyskać zdecydowanie lepsze efekty. I nie mam na myśli tutaj wyłącznie podkręcania, ale także, a może przede wszystkim, poprawę kultury pracy. Dość powiedzieć, że czasem, nieoczekiwanie, można upiec dwie przysłowiowe pieczenie na jednym ogniu. Pamiętacie jeszcze przytoczony powyżej przykład Radeona RX Vega 64? Okazuje się, że wiele egzemplarzy potrafi stabilnie pracować przy napięciu 1,0 V, bez redukcji taktowań. Mało tego, akcelerator staje się wówczas chłodniejszy, przez co utrzymuje częstotliwości wyższe, niż przy ustawieniach fabrycznych. To oczywiście przypadek skrajny, ale dobitnie obrazujący, dlaczego optymalizacja karty graficznej jest kwestią istotną.

Jednocześnie, nie można zapominać o tzw. limitach mocy (ang. power limits). Współczesne karty graficzne są projektowane tak, by mieścić się w określonym, z góry, budżecie energetycznym. Rdzeń graficzny pracuje z dynamiczną częstotliwością, która, kiedy tylko zużycie energii staje się zbyt wysokie, zostaje stosownie obniżona. Napięcie w bezpośredni sposób wpływa na zapotrzebowanie karty, a zatem, po ustawieniu na zbyt wysoką wartość, może spowodować spadek wydajności. Co oczywiste, sam limit mocy również można podnieść, ale wtedy narażamy się na jeszcze wyższe prądy, czyli pogłębiamy potencjalne problemy termiczne. I tak, undervolting wpływa korzystnie na pracę Radeona RX Vega 64 nie tylko z uwagi na temperatury, ale także zbyt ciasny limit mocy, który niejako uwalniamy, zmniejszając napięcie zasilające.

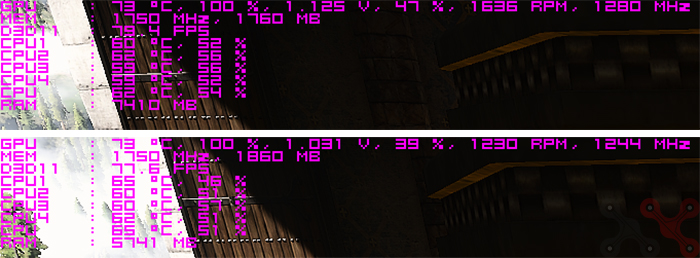

Zrzucenie napięcia o 0,1 V, na karcie Gigabyte AORUS Radeon RX 570 4 GB, pozwoliło obniżyć prędkość wentylatorów o średnio 400 obr./min, kosztem utraty ledwie 36 MHz, na zegarze taktującym rdzeń graficzny

Nie zawsze rzeczywistość jest na tyle aksamitna, aby uwolnić od kompromisu, ale pole do manewru wciąż pozostaje, w każdym scenariuszu. Wydajność nie jest bowiem wprost proporcjonalna do częstotliwości zegara taktującego (jest zbyt wiele składowych), szczególnie w specyficznych zastosowaniach, chociażby przetwarzaniu blockchain, niezbędnym kryptowalutom. Doskonały przykład stanowi w tym miejscu zintegrowany Radeon RX Vega 11, który limitowany jest przepustowością pamięci, a windowanie samej częstotliwości pracy rdzenia nie ma sensu. Lepiej więc ustawić zegar tak, by nie musieć podnosić napięcia, bo nie wiąże się to z większym zyskiem, jedynie zwiększa temperatury i pobór energii elektrycznej. A jeśli już o poborze energii mowa, to nie należy zapominać, jak istotnym aspektem jest on dla wydobycia kryptowalut. I właśnie dlatego górnicy obniżają napięcia swych kart, często wraz z taktowaniami, poszukując punktu gwarantującego najlepszy stosunek efektywności do kosztów. Analogicznie, undervoltingiem powinni zainteresować się choćby posiadacze małych obudów ITX, którzy zmagają się z problemem wysokich temperatur.

Tutaj bezwzględnie warto nadmienić, że o ile overvolting w nadmiarze może być dla sprzętu szkodliwy, o tyle undervolting jest zawsze bezpieczny. Jeśli przesadzimy z obniżaniem napięcia, to narazimy się najwyżej na niestabilność platformy, nie jej trwałe uszkodzenie. Szczerze powiedziawszy, overvolting, w dzisiejszych czasach, również skrajnie ryzykowny nie jest. Producenci skalują zakres regulacji programowej tak, by krzywdy karcie graficznej nie zrobić. Dopiero zdejmowanie narzuconych limitów, przez edycję BIOS-u, można uznać za zachowanie niebezpieczne, do czego mniej doświadczonych zdecydowanie nie zachęcam.

.png?time=1519084578103)

Karty z rodziny RX Vega są jednym z najlepszych przykładów wykorzystania undervoltingu

Konkludując, manipulacja napięciem zasilającym jest czynnością niezwykle istotną, patrząc z perspektywy świadomego użytkownika, który chce wykrzesać maksimum potencjału użytkowego z posiadanej grafiki. Jest przy tym, w granicach rozsądku, zabiegiem niezwykle prostym. Wszystko, co należy zrobić, to przesunąć odpowiedni suwak w aplikacji pokroju MSI Afterburner czy Zotac FireStorm. Efekty optymalizacji mogą być natomiast naprawdę zadowalające, o czym, nawiasem mówiąc, pisałem już chociażby przy okazji testowania Radeona RX 570, od Gigabyte / AORUS. A wszystko dlatego, że produkty dostępne w sklepach wymagają pewnego ujednolicenia, niezbędnego przy produkcji masowej, co w kontekście losowości układów krzemowych stanowi oczywisty mankament. Niestety, jako iż potencjalnych zmiennych jest zbyt wiele, ciężko pisać o uniwersalnej recepcie na satysfakcjonujący wynik końcowy. Jedni napięcie będą obniżać, drudzy zaś - podnosić, dokładając do tego przyśpieszenie zegara taktującego. Wiele zależy też od posiadanego modelu karty graficznej. Tak czy inaczej, moim zdaniem, każdej karcie graficznej zdecydowanie warto poświęcić dłuższą chwilę.

Zobacz także:

Undervolting AMD Radeon RX 580, 570, 480 oraz 470, w praktyce

Jak ustawić wydajny PC tak, aby pracował oszczędnie

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Overvolting i undervolting karty graficznej – na co komu zmiana napięć?