Branża pamięci HBM przeżywa boom ze względu na popyt na sztuczną inteligencję, co przełożyło się na gigantyczny wzrost cen HBM o 500%, a na horyzoncie nie widać żadnych oznak spowolnienia.

Nienasycony popyt na procesory graficzne AI i wszystko, co związane ze sztuczną inteligencją w roku 2023, spowodował, że producenci pamięci HBM odnotowali gigantyczny, 500% wzrost średniej ceny sprzedaży chipów HBM. To dobre wieści dla Microna, Samsunga i SK hynix, zdecydowanie gorsze dla ich klientów, korzystających z tego rodzaju pamięci, jak np. NVIDIA czy AMD.

Producenci pamięci HBM odnotowali gigantyczny, 500% wzrost średniej ceny sprzedaży chipów HBM.

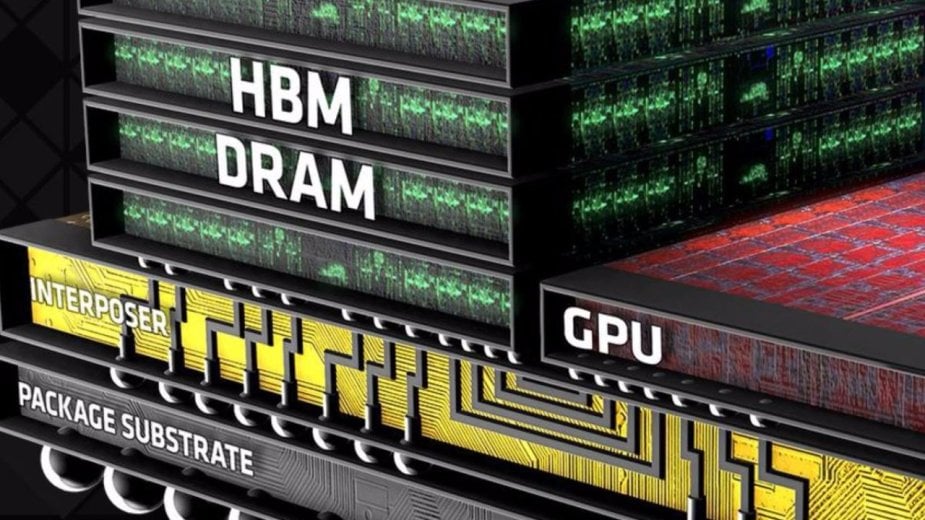

Chipy HBM są jedną z najważniejszych części GPU dedykowanych AI i AMD oraz NVIDIA korzystają z najnowocześniejszej pamięci HBM w swoich akceleratorach sztucznej inteligencji. Firma analityczna Yole Group przewiduje, że podaż HBM będzie rosła w rocznym tempie 45% od 2023 do 2028 r., przy czym oczekuje się, że ceny HBM pozostaną wysokie „przez jakiś czas”, biorąc pod uwagę, jak trudno jest zwiększać produkcję HBM, aby nadążyć za ogromnym popytem.

Samsung i SK hynix to dominujący gracze na rynku pamięci HBM. Firmy z Korei Południowej mają 90% udziału w rynku HBM, a Micron musi zadowolić się resztkami. SK hynix i TSMC (Taiwan Semiconductor Manufacturing Company) łączą siły, dzięki czemu mamy do czynienia z kilkoma interesującymi rozwiązaniami, które będą się pojawiać w najbliższych miesiącach i latach.

SK hynix zapowiedziało niedawno, że pamięć HBM4 nowej generacji wejdzie do masowej produkcji w roku 2026 i będzie gotowa na obsługę układów graficznych AI nowej generacji, wykraczających poza nadchodzące GPU NVIDIA Blackwell B100 AI. HBM to kluczowy element akceleratorów AI, ponieważ twórcy tego typu GPU chcą (i potrzebują) najszybszej dostępnej pamięci.

Nadchodzące GPU NVIDIA H200 AI będzie miało na pokładzie do 141 GB pamięci HBM3e, podczas gdy H100 będzie miał na pokładzie 80 GB pamięci HBM3. Nowy procesor graficzny AMD Instinct MI300X AI wyposażony jest w 192 GB pamięci HBM3, więc Zieloni korzystają z szybszego wariantu, ale Czerwoni wykorzystują więcej chipów HBM w swoich profesjonalnych grafikach.

HBM4 będzie ogromnym skokiem wydajnościowym i aż dziw bierze, że NVIDIA zdecydowała się pominąć ten standard w przypadku generacji Blackwell. SK hynix niedawno zwiastowało swoją pamięć HBM4, twierdząc, że jej opracowywanie rozpocznie się w 2024 r. Powinniśmy zobaczyć pierwsze próbki pamięci HBM4 z 36 GB na stos, co pozwala na użycie aż do 288 GB pamięci HBM4 na GPU AI nowej generacji.

Pokaż / Dodaj komentarze do: Cena pamięci HBM skoczyła aż o 500%. Producenci zacierają ręce