Zgodnie z planem NVIDIA na konferencji GTC ogłosiła szereg produktów korporacyjnych zorientowanych na sztuczną inteligencję. Najważniejszą zapowiedzią jest niewątpliwie nowa architektura Hopper, ale ujawniono także pierwsze GPU dla centrum danych zbudowane przy użyciu tej technologii, czyli H100, nowy superchip CPU Grace, a także przedstawiono zbudowania plany najszybszego na świecie superkomputera AI o nazwie Eos.

Nvidia bardzo mocno stawia na AI w ostatniej dekadzie, a jej GPU dość powszechnie wykorzystują metody głębokiego uczenia się. Wraz ze wzrostem zapotrzebowania sektora AI na przetwarzanie danych, NVIDIA chce jeszcze mocniej postawić na ten element w swoich produktach. Firma podkreśliła popularność systemu uczenia maszynowego znanego jako Transformer, gdyż metoda ta okazała się niezwykle owocna, napędzając wszystko, od modeli językowych, takich jak GPT-3 OpenAI, po systemy medyczne, takie jak AlphaFold firmy DeepMind. Takie modele odnotowywały wykładniczy wzrost na przestrzeni kilku lat. Na przykład, kiedy OpenAI uruchomił GPT-2 w 2019 roku, ten zawierał 1,5 miliarda parametrów (lub połączeń), a zaledwie dwa lata później Google wytrenowało podobny model, używający 1,6 biliona parametrów.

Zgodnie z planem NVIDIA na konferencji GTC ogłosiła szereg produktów korporacyjnych, bazujących na architekturze Hopper.

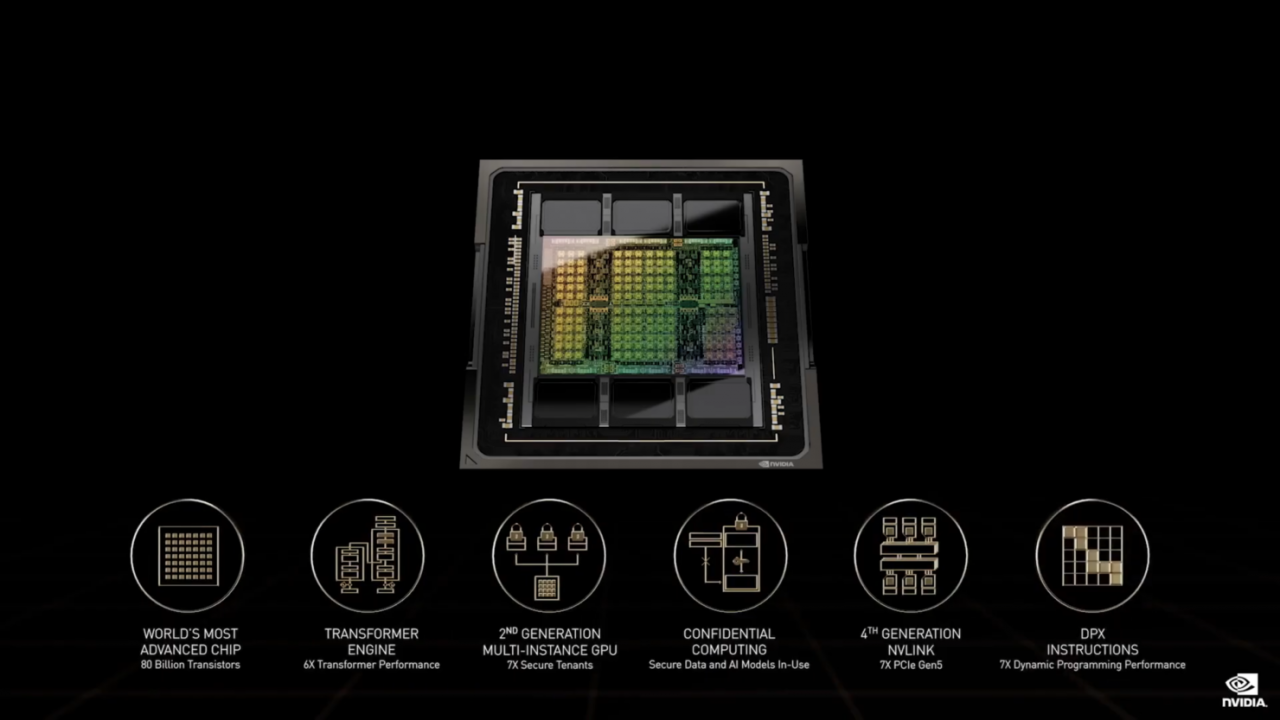

„Szkolenie tych gigantycznych modeli wciąż trwa miesiącami” – powiedział starszy dyrektor ds. zarządzania produktem NVIDII Paresh Kharya podczas briefingu prasowego. „Więc odpalasz pracę i czekasz półtora miesiąca, aby zobaczyć, co się stanie. Kluczowym wyzwaniem związanym ze skróceniem tego czasu na szkolenie jest to, że wzrost wydajności zaczyna spadać wraz ze wzrostem liczby GPU w centrum danych”. Zieloni twierdzą, że ich nowa architektura Hopper pomoże zniwelować te trudności. Nazwana na cześć pionierki informatyki i kontradmirał marynarki wojennej Stanów Zjednoczonych, Grace Hopper, architektura specjalizuje się w sześciokrotnym przyspieszeniu treningu modeli Transformer na procesorach graficznych H100 w porównaniu z układami poprzedniej generacji, podczas gdy nowa, czwarta już generacja NVIDIA NVlink, może podłączyć do 256 GPU H100 o dziewięciokrotnie większej przepustowości niż poprzednia generacja.

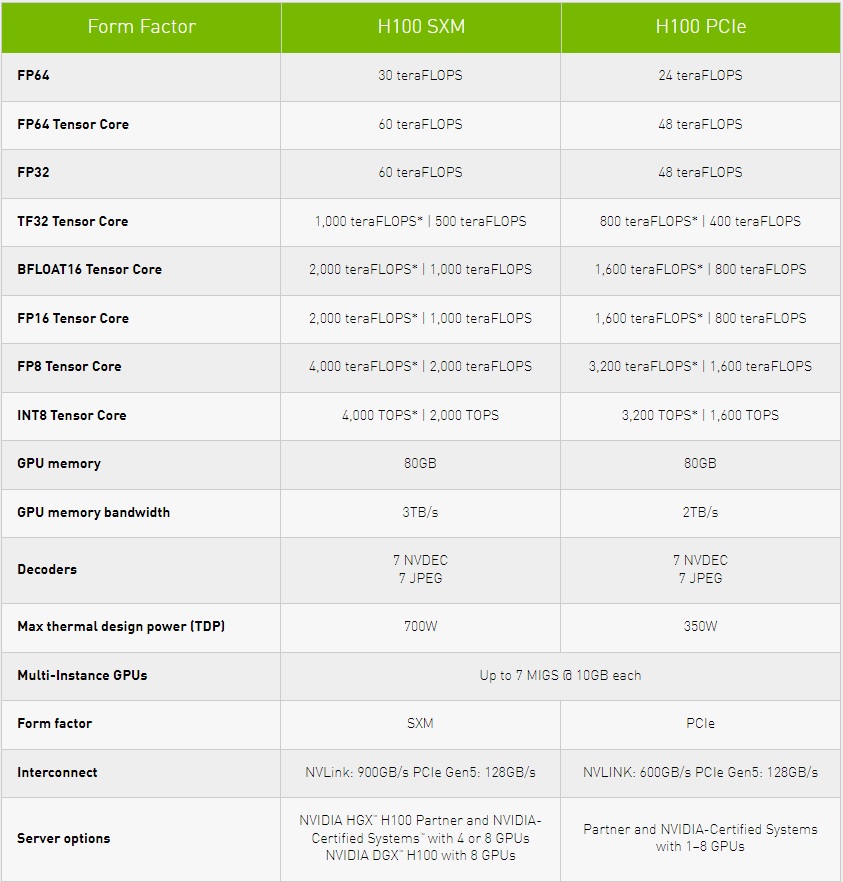

Sam procesor graficzny H100 zawiera 80 miliardów tranzystorów i jest pierwszym GPU obsługującym PCle Gen5 i wykorzystującym 80 GB pamięci HBM3, co umożliwia przepustowość pamięci na poziomie 3 TB/s. Producent twierdzi, że H100 jest trzy razy szybszy niż A100, czyli GPU poprzedniej generacji, przy obliczeniach FP16, FP32 i FP64 i sześć razy szybszy przy 8-bitowej zmiennoprzecinkowej matematyce. Pełna implementacja tego układu oferuje 144 jednostki SM i 16896 rdzeni FP32, a TDP wynosi tu 700 W. „W przypadku treningu gigantycznych modeli Transformer, H100 zaoferuje nawet dziewięciokrotnie wyższą wydajność, trenując w kilka dni to, co zwykle trwało tygodnie” - powiedział Kharya.

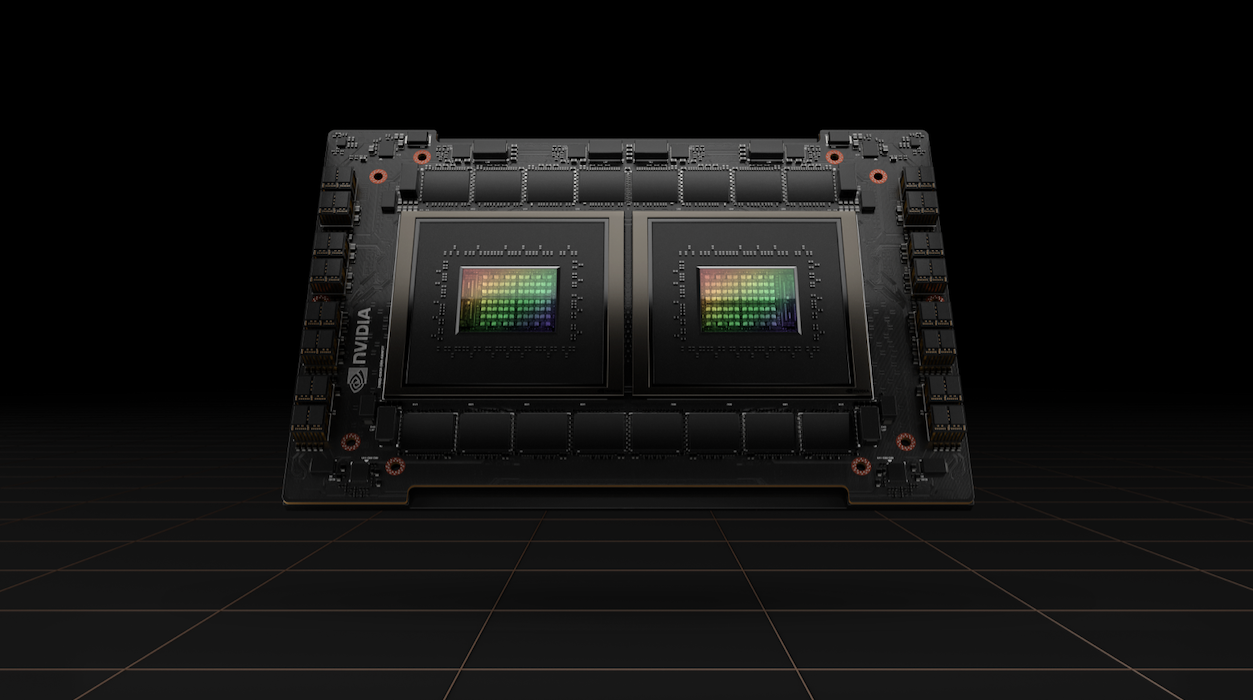

Firma ogłosiła również nowy procesor centrum danych, Grace CPU Superchip, który składa się z dwóch CPU połączonych bezpośrednio przez nowy NVLink-C2C o niskim opóźnieniu. Chip został zaprojektowany do „obsługi aplikacji HPC i AI na wielką skalę” wraz z nowymi GPU opartymi na Hopper i może być używany w systemach z samym procesorem lub serwerach akcelerowanych przez GPU. Posiada 144 rdzenie Arm i przepustowość pamięci 1 TB/s, a jest to także pierwsza platforma obsługująca pamięci LPDRR5X z włączonym ECC. Przepustowość pamięci wynosić ma tu 1 TB/s, a TDP Grace CPU Superchip wynosić może nawet 500 W.

Oprócz nowości dotyczących sprzętu i infrastruktury NVIDIA ogłosiła również, że buduje nowy superkomputer AI, który, jak twierdzi, będzie najszybszy na świecie. Superkomputer o nazwie Eos zostanie zbudowany w oparciu o architekturę Hopper i będzie zawierał około 4600 GPU H100, które zapewnią 18,4 eksaflopsów „wydajności sztucznej inteligencji”. System będzie używany tylko do wewnętrznych badań Zielonych, a firma zapowiedziała, że powinien wystartować za kilka miesięcy. Podczas swojego wystąpienia dyrektor generalny NVIDII, Jensen Huang, powiedział, że Eos, uruchamiając tradycyjne zadania superkomputera, mógłby zapewnić 275 petaFLOPSów mocy obliczeniowej – 1,4 raza więcej niż „najszybszy komputer naukowy w USA” (Summit). „Spodziewamy się, że Eos będzie najszybszym komputerem AI na świecie” — powiedział Huang. „Eos będzie podstawą najbardziej zaawansowanej infrastruktury AI dla naszych producentów OEM i partnerów w chmurze”.

Zobacz także:

- Ukradli 20 sztuk GeForce'ów RTX 3070 Ti z magazynu i próbowali sprzedać je w lombardzie

- Apple twierdzi, że ich GPU w M1 Ultra jest wydajne jak RTX 3090. Trochę ich poniosła wyobraźnia...

- Chip Apple M1 Ultra jest ogromny. Kolejne benchmarki pokazują manipulacje Apple

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

NVIDIA zapowiada GPU Hopper, Grace CPU Superchip i zwiastuje najpotężniejszy superkomputer