Kwestia wydajności procesorów w grach w połączeniu z GPU różnych producentów to niewątpliwie rzecz ciekawa, która nie była od dłuższego czasu poruszana na łamach ITHardware, w związku z czym postanowiłem to nadrobić, gdyż ostatni materiał tego typu ukazał się jeszcze przed dołączeniem Intela do walki o portfele graczy. Osiągi CPU są istotne, gdyż im są wyższe, tzn. im bardziej dopracowane pod tym kątem sterowniki ma układ graficzny, tym dostajemy lepszy komfort rozgrywki, w postaci mniej odczuwalnych spadków w sytuacjach, gdy to procesor jest czynnikiem ograniczającym wydajność, a więc tzw. wąskim gardłem. Teoretycznie w erze DirectX 12 można by się spodziewać, że różnice w tym aspekcie będą mniejsze niż za czasów DirectX 11, ale czy tak właśnie jest w istocie, szczególnie w kontekście niebieskich, przekonacie się niebawem.

Spis treści:

- Platforma testowa, metodologia

- Wydajność - A Plague Tale: Requiem, Call of Duty: Modern Warfare 3

- Wydajność - Counter-Strike 2, Cyberpunk 2077, Dragon's Dogma 2

- Wydajność - Dying Light 2, Dziedzictwo Hogwartu, Far Cry 6

- Wydajność - Dead Island 2, Spider-Man: Miles Morales, SW Jedi: Ocalały

- Wydajność - Starfield, Wiedźmin 3: Dziki Gon NG, World of Tanks

- Wydajność - średnie osiągi

- Podsumowanie

A skoro wspomniałem o Intelu, warto nadmienić, że w sieci nie brak doniesień o niewystarczającej optymalizacji sterowników tej firmy od strony wydajności CPU w grach. Recenzenci wzięli ten temat na tapet po premierze Arc B580, a typowa jego realizacja to porównanie wspomnianego GPU oraz np. zielonego rywala GeForce RTX 4060, ale nie we współpracy z procesor z platformy testowej kart graficznych, lecz innymi, starszymi i mniej wydajnymi CPU. Ten materiał będzie jednak inny, jako że postanowiłem przygotować test procesorów w grach w połączeniu z różnymi układami graficznymi w sensie stricte, a więc bez tricków w postaci leciwych CPU oraz przede wszystkim bez jakiegokolwiek ograniczania osiągów przez GPU. Innymi słowy, nie jest to porównanie mieszane CPU/GPU, ale czysty test procesorowy. Zobaczmy więc, w jaki sposób osiągnąłem ten cel.

Wydajność procesorów w połączeniu z różnymi GPU to w ostatnim czasie popularny temat. Zobaczmy, jak dobre sterowniki mają AMD, Intel oraz NVIDIA.

![]() Test Intel Arc B580. Cena dobra, ale gdzie jest haczyk?

Test Intel Arc B580. Cena dobra, ale gdzie jest haczyk?

Krótki komentarz odnośnie przeprowadzonych pomiarów

W niniejszej, pierwszej części cyklu pod lupę trafiają nowoczesne platformy Intela, tj. LGA 1700, a więc najlepszy ekosystem dla graczy w portfolio niebieskich, oraz LGA 1851, na którą wydane zostały CPU z rodziny Arrow Lake. Z kolei konkretne procesory to Core i7-12700K i Core Ultra 5 245K, oba o podobnych osiągach w zastosowaniach rozrywkowych. Nie brałem tu pod uwagę topowych modeli dla tych podstawek, gdyż jak wspomniałem, uniknięcie wąskiego gardła ze strony GPU było ważnym założeniem testu, a przy mocniejszych procesorach byłoby to trudne w połączeniu z Arc B580, czyli układem graficznym, nie oszukujmy się, z niskiej półki wydajnościowej. Z uwagi na to, że wspomniane GPU nie jest demonem szybkości, pomiary zostały wykonane w rozdzielczości 720p, aby mieć pewność, że nie ma wąskiego gardła. Gwoli przypomnienia, w testach stricte procesorowych (tj. bez ograniczania przez kartę graficzną) rozdzielczość nie ma wpływu na FPS, tak więc nie jest to błąd (zainteresowanych odsyłam do felietonów na temat mierzenia wydajności CPU w grach, które znajdziecie tutaj oraz tutaj).

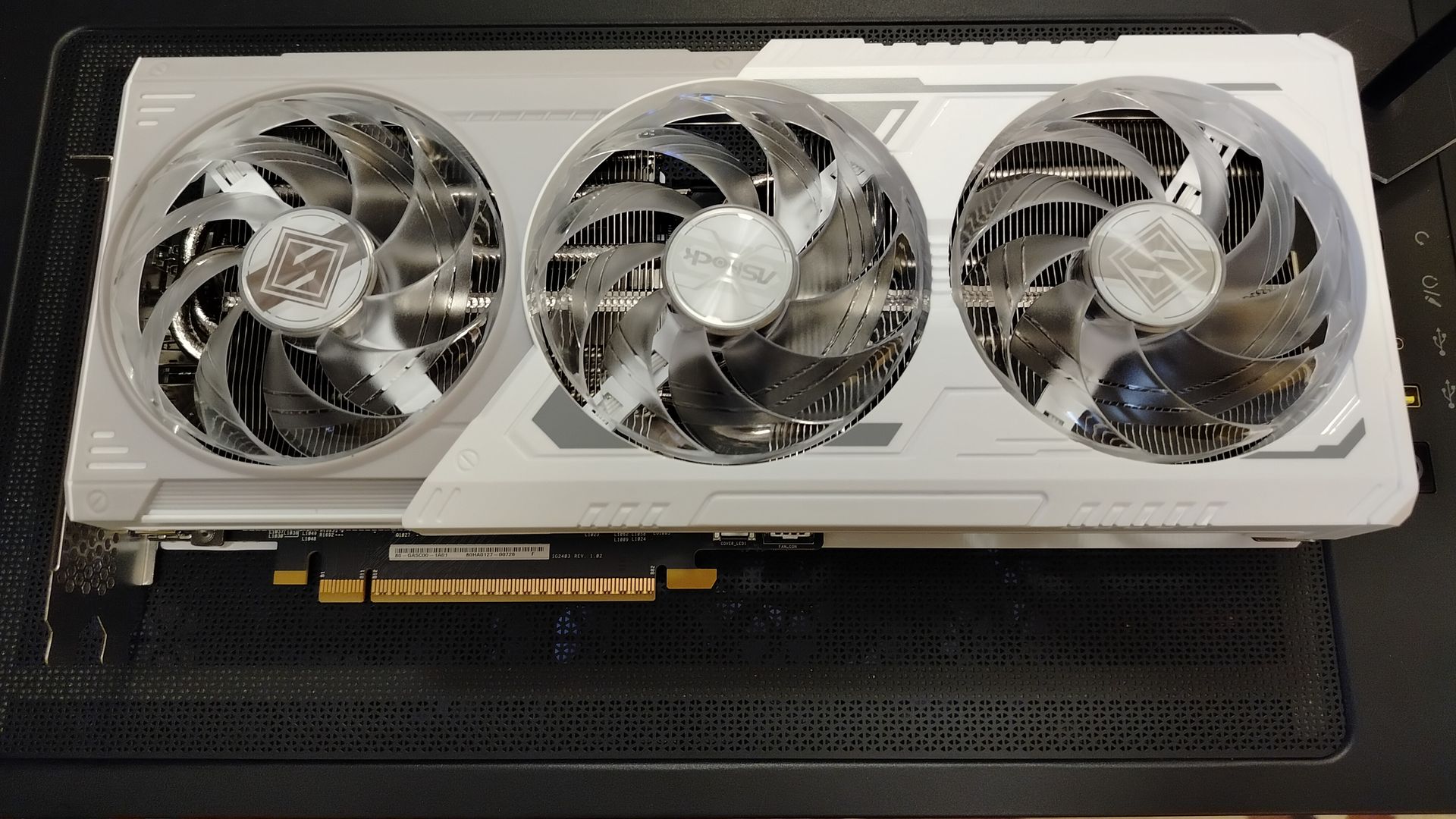

Zostaje jeszcze kwestia doboru GPU innych producentów, która jak się domyślam, tak jak rozdzielczość może być dla Was kontrowersyjna, więc trzeba ją wyjaśnić. Mianowicie zostały użyte modele z wyższej półki, a konkretnie Radeon RX 7900 XTX oraz GeForce RTX 4080. Dlaczego takie, a nie rywale Arca B580? Bynajmniej nie dlatego, by zrobić niebieskim na złość, lecz ponownie ze względu na cel, którym był brak wąskich gardeł. Trochę uprzedzając wykresy wydajności, w skrajnym przypadku procesory były w stanie wygenerować ponad dwukrotnie więcej FPS we współpracy z GPU od AMD czy NVIDII niż w połączeniu z układem Intela, co w przypadku rodzin GeForce oraz Radeon wymaga odpowiedniej mocy karty graficznej, by nie pojawiło się ograniczanie przez nią osiągów. Ponadto pamiętajmy o słabszej dyspozycji architektury RDNA 3 z włączonym śledzeniem promieni, a takie porównania też zostały wykonane, w związku z czym wolałem wziąć GPU na zapas, aby nie było wąskiego gardła po aktywacji RT. W żaden sposób nie wpływa to na rzetelność wyników, gdyż w momencie, gdy jesteśmy już na limicie procesora, a nie karty graficznej (czyli GPU jest wystarczająco szybkie), wtedy dalsze zwiększanie mocy układu graficznego po prostu nie podnosi FPS.

Test osiągów CPU z GPU Arc, GeForce i Radeon: metodologia

Wszystkie testy zostały wykonane pod kontrolą systemu operacyjnego Windows 11 64-bit 23H2 oraz sterowników AMD Software: Adrenalin 25.3.1, Intel Graphics Driver 32.0.101.6737 i NVIDIA GeForce Game Ready Driver 576.28, podczas rzeczywistej rozgrywki. Do pomiaru liczby klatek użyto programu Fraps w wersji 3.5.99 - w tym dla DirectX 12 (jedyna niedogodność pod tym API to brak OSD). Rezultaty umieszczone na wykresach są średnią arytmetyczną wyników z trzech odrębnych przebiegów, z kolei rozdzielczość zegara czasu rzeczywistego była ustawiona na sztywną wartość 0,5 ms.

Nastawy pamięci prezentują się następująco:

- DDR5-7000 MHz CL 34-42-42-76 2T.

Limity mocy były ustawione na następujących poziomach:

- Intel Core Ultra 5 245K: PL1 = PL2 = 125 W,

- Intel Core i7-12700K: PL1 = PL2 = 125 W.

Uwagi dodatkowe do testów:

- tryb kontrolera pamięci RAM to Gear 2,

- w obu przypadkach zoptymalizowałem timingi dalszych rzędów,

- ze względu na niewystarczającą optymalizację zrównoważonego planu zasilania, Arrow Lake był testowany po zmianie na wysoką wydajność.

Platforma testowa

|

ASUS ROG MAXIMUS Z790 APEX ENCORE |

|

ASUS ROG STRIX B860-F GAMING WIFI |

|

Patriot Viper Venom RGB 2x16 GB DDR5-7400 CL36 |

| Patriot Viper VP4100 1 TB | |

|

SilentiumPC Supremo M1 Platinum 700 W |

|

Antec Twelve Hundred V3 |

| MSI MEG CORELIQUID S360 |

Test osiągów CPU z GPU Arc, GeForce i Radeon: wydajność

Pomiary w grze A Plague Tale: Requiem wykonuję w rozdziale Co pozostało, gdzie bohaterowie muszą przedostać się przez obszar "zablokowany" przez szczurzą armię. To wysoce wymagająca lokalizacja, która w dodatku dobrze (jak na tę grę) korzysta z wielowątkowości. Z kolei w Call of Duty: Modern Warfare 3 zdecydowałem się postawić na misję Cenny towar, jako że to jedno z niewielu miejsc, które są wymagające oraz powtarzalne (wahania FPS w zakresie nawet kilkudziesięciu klatek podczas patrzenia w jeden punkt to norma w większości innych lokalizacji).

A Plague Tale: Requiem

Call of Duty: Modern Warfare 3

Counter-Strike 2, Cyberpunk 2077, Dragon's Dogma 2

Counter-Strike 2 to dość ciekawy przypadek, jako że mapa Ancient jest jedyna w swoim rodzaju, tzn. jej obszar z wodą jest ekstremalnie wymagający jak na standardy tej produkcji, co widzimy dla wartości minimalnych. Z tego powodu główny scenariusz to Inferno, tym bardziej, że jest nienagannie powtarzalny, czego o Ancient powiedzieć nie można. Z kolei Cyberpunk 2077 i Dragon's Dogma 2 to produkcje, które dużo bardziej dają się procesorom we znaki, obydwie testowane też z włączonym śledzeniem promieni, choć w ich przypadku nie ma to dużego wpływu na liczbę FPS.

Counter-Strike 2

Cyberpunk 2077

Dragon's Dogma 2

Dying Light 2, Dziedzictwo Hogwartu, Far Cry 6

Wszystkie gry z tej sekcji obsługują śledzenie promieni, stąd znajdziecie dodatkowe testy z włączonym RT. Wpływ tej opcji na wydajność jest największy dla Dziedzictwa Hogwartu, umiarkowany dla Dying Light 2 oraz niewielki w przypadku Far Cry 6. Skupiając się jeszcze przez chwilę na polskim tytule, miejsce testowe zostało dobrane w taki sposób, aby lokalizacja była wymagająca tak dla niskiego, jak i wysokiego mnożnika LOD. To istotne, gdyż trafiają się miejsca, które stanowią wyzwanie dla procesorów przy umiarkowanej wartości LOD, ale niemal nie reagują na jej zwiększanie, podczas gdy gdzie indziej spadek jest znaczny, stąd właściwy wybór scenariusza jest kluczowy.

Dying Light 2

Dziedzictwo Hogwartu

Far Cry 6

Dead Island 2, Spider-Man: Miles Morales, SW Jedi: Ocalały

Spider-Man: Miles Morales oraz STAR WARS Jedi: Ocalały to kolejne produkcje, w których aktywacja RT powoduje znaczny wzrost wymagań w stosunku do CPU. Niemniej druga z tych gier ma inną charakterystykę od Dziedzictwa Hogwartu, choć obie bazują na silniku Unreal Engine 4. Mianowicie dla STAR WARS Jedi: Ocalały użycie procesora po włączeniu RT wzrasta, a nie spada (tytuł jest wtedy w stanie spożytkować ~16 wątków). Z kolei w Dead Island 2 testy odbywają się w ramach nowego dodatku SoLA, którego akcja rozgrywa się na dużej, otwartej mapie, a to optymalny scenariusz do porównywania wydajności CPU.

Dead Island 2

Spider-Man: Miles Morales

STAR WARS Jedi: Ocalały

Starfield, Wiedźmin 3: Dziki Gon NG, World of Tanks

Starfield to w pewnym sensie gra legendarna, bo z pewnością na taki tytuł zasługuje w gronie optymalizacyjnych gniotów. Ale co ciekawe, z najnowszymi poprawkami od strony CPU to całkiem sensowna produkcja, o wysokich, ale jednak nie zabójczych wymaganiach, oraz dobrze radząca sobie z wielowątkowością. Jej przeciwieństwem jest Wiedźmin 3: Dziki Gon w wersji Next-Gen, która niespecjalnie potrafi wykorzystać potencjał wielu rdzeni, przez co bardziej bazuje na mocy pojedynczego wątku. Natomiast w World of Tanks zmieniłem scenariusz testowy, jako że wcześniej używana powtórka przestała działać po zaktualizowaniu gry, jednak nie ma powodów do obaw, bo nowe miejsce także jest całkiem wymagające jak na standardy tego tytułu.

Starfield

Wiedźmin 3: Dziki Gon NG

World of Tanks

Średnie osiągi

W tej sekcji zamieszczone są wykresy, które prezentują średnią wydajność procesorów z różnymi GPU, w trzech wariantach: dla wszystkich testów, wyłącznie dla pomiarów bez śledzenia promieni, a także tylko dla scenariuszy z aktywnym RT. Jak za chwilę zobaczycie, wybrana opcja ma pewien wpływ na zależności między poszczególnymi wariantami współpracy z układami graficznymi.

Ważne: Wartości widoczne na wykresach zostały policzone na podstawie relacji procentowych w poszczególnych testach, a nie np. poprzez zsumowanie liczby kl./s, co jest metodą niepoprawną zarówno z matematycznego, jak i praktycznego punktu widzenia, jako że takie podejście powoduje większą wagę gier, w których procesory osiągają wyższy FPS, zaś intuicyjnie wiemy, że przewaga w takim wariancie jest mniej istotna niż różnica w tytułach, gdzie wydajność jest niższa.

Test osiągów CPU z GPU Arc, GeForce i Radeon: konkluzje

Wykonane testy pokazały kilka interesujących rzeczy. Zaczynając od wydajności Arrow Lake w grach, jak wiecie, aspekt ten okazał się rozczarowujący w chwili premiery, a od tego czasu zbadałem nowe BIOS-y z usprawnionym mikrokodem oraz poprawki do systemu Windows 11 24H2, które w obu wypadkach nie przyniosły poprawy. Teraz sprawdziłem nowe sterowniki graficzne, które w teorii mogą mieć jakieś optymalizacje pod najświeższą platformę Intela, choć i one nic nie zmieniły - w dalszym ciągu Core Ultra 5 245K jedynie ledwie dorównuje Core i7-12700K, tj. CPU sprzed trzech generacji, do tego nie topowemu. Druga sprawa to jakość sterowników AMD oraz NVIDII od strony osiągów procesorów w grach, która jest zbliżona. Dla DirectX 11 lekka przewaga jest po stronie zielonych, ale w przypadku DirectX 12 nie ma reguły, tzn. czasem wygrywa połączenie z GeForcem, a czasem z Radeonem. Uśredniając, mamy ledwie ok. 2% przewagę NVIDII dla Core i7-12700K i 0,5% dla Ultra 5 245K, czyli pomijalną.

Sterowniki AMD i NVIDII wypadają podobnie, jeśli chodzi o wydajność CPU w grach, ale Intel wciąż ma bardzo dużo pracy do wykonania.

![]() Arrow Lake vs Raptor Lake bez HT - test w grach. Czy brak SMT obniża osiągi?

Arrow Lake vs Raptor Lake bez HT - test w grach. Czy brak SMT obniża osiągi?

Jakość sterowników Intela od strony osiągów CPU w grach i słowo końcowe

Zupełnie inaczej wygląda to dla sterowników Intela, które delikatnie mówiąc, szału nie robią. Najgorzej osiągi CPU we współpracy z układem Arc B580 wyglądają w A Plague Tale: Requiem, CoD: Modern Warfare 3 (nawet ponad dwukrotna strata do rywali!), Counter-Strike 2, Spider-Man: Miles Morales (szczególnie z RT), a także Starfield. W przypadku tego ostatniego tytułu dla Core Ultra 5 245K pojawiły się okropne przycięcia, widoczne w minimalnym FPS. Na pocieszenie, trafiają się też gry, gdzie strata jest względnie niewielka, a nawet takie, gdzie jest z grubsza remis - patrz Cyberpunk 2077 czy Dragon's Dogma 2. Odnośnie gry CD Projekt RED, w teście graficznym RX 7900 XTX czy RTX 4080 oczywiście nokautują Arca B580, ale jak pisałem we wstępie, nie ma to żadnego znaczenia, bo w ramach niniejszego artykułu zostały przygotowane porównania stricte procesorowe, przez co różnica mocy GPU nie ma znaczenia, a tylko jakość sterowników - trudno o lepszy dowód, że tak jest w istocie. A nawiązując jeszcze do średniej, oprogramowanie AMD oraz NVIDII okazało się szybsze o ~16-19%, co nie jest dramatyczna różnicą, ale średnia w tym przypadku trochę zaciemnia sprawę, ponieważ nie zapominamy o podanych wyżej przykładach, gdzie Intel wypada wręcz fatalnie.

Wracając jeszcze do CoD: Modern Warfare 3, dla tej gry widzimy negatywny wpływ ReBAR na osiągi CPU, wszak po wyłączeniu tej opcji konfiguracja z Radeonem odnotowała ogromne przyspieszenie. GeForce'y nie mają takiego problemu, gdyż NVIDIA zablokowała Resizable BAR dla tej produkcji w sterowniku, ale po ręcznym jej włączeniu sytuacja jest dokładnie taka sama. Niestety, dla układów od Intela nie można skorzystać z tej sztuczki, ponieważ wymagają one ReBAR do poprawnego działania... Reasumując, kondycja oprogramowania niebieskich od strony optymalizacji funkcjonowania procesorów w grach jest po prostu kiepska. Aktualnie, z uwagi na relatywnie niskie osiągi GPU firmy Intel, ma to znaczenie głównie w zestawieniu ze starszymi procesorami, ale to realny problem, gdyż karty graficzne z tego segmentu często kupują ludzie, którzy chcą ulepszyć swój komputer bez zmiany całej platformy. Do tego np. w Spider-Man: Miles Morales model Arc B580 ma wystarczająco dużo mocy, żeby w 1080p z RT wygenerować ponad 60 FPS, ale potrzebuje do tego CPU kosztującego z grubsza tyle co karta graficzna - to też istotna wada! Duże problemy zaczną się jednak dopiero po premierze mocniejszych Arców, dla których nawet szybkie procesory mogą okazać się niewystarczające. Co tu więcej pisać, jeżeli niebiescy chcą na dobre zaistnieć na rynku GPU, to ich dział programowy musi się ostro wziąć do pracy i tym wnioskiem żegnam się z Wami.

Karty graficzne do testów dostarczyli:

Procesory do testów dostarczył:

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Wydajność procesorów z GPU firm AMD, Intel i NVIDIA - cz. 1, LGA 1700 i LGA 1851