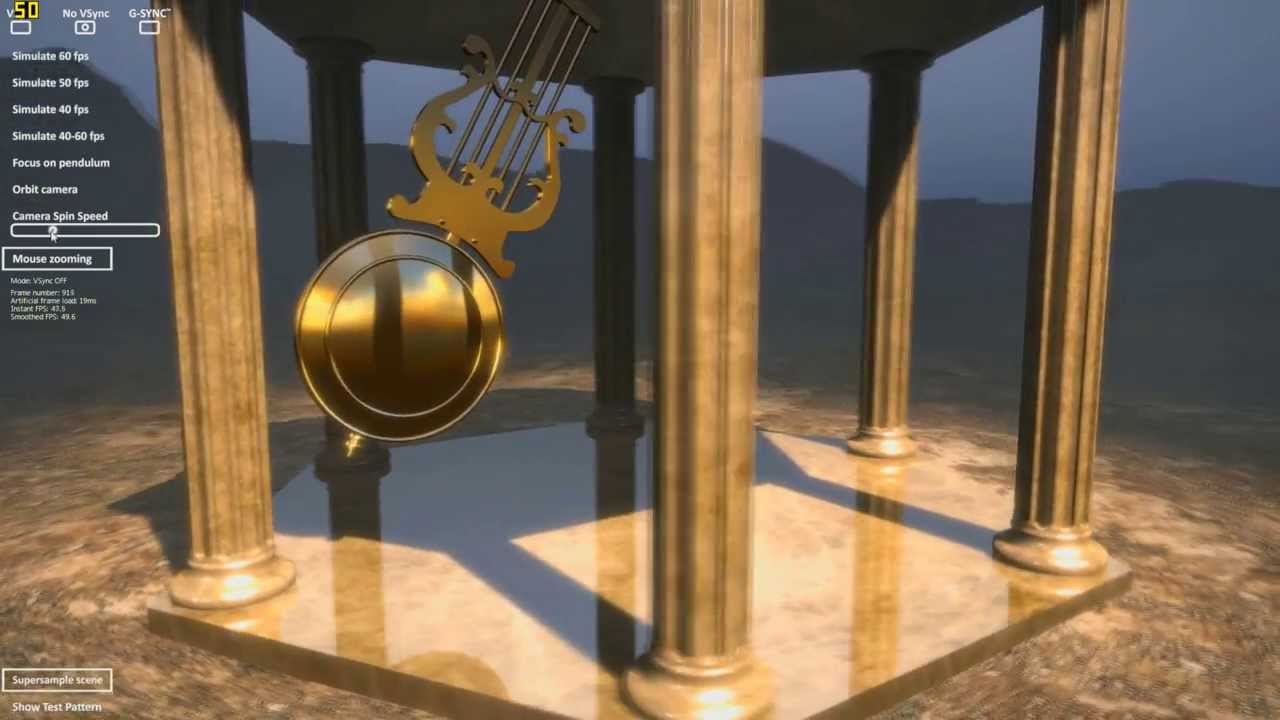

Do testów wykorzystaliśmy monitor Gigabyte AORUS AD27QD (odsyłamy do naszego testu), a także kartę graficzną GIGABYTE GeForce RTX 2070 GAMING OC 8G (nasz test). Zanim przeszliśmy do samych gier, wykonaliśmy syntetyczne benchmarki, czyli dwa testy od Blur Busters - UFO Test: G-SYNC Demo of Variable Refresh Rates i UFO Test: Demo of Stutters and Tearing oraz demo Pendulum, które wypuszczano przed laty, by zobrazować różnice pomiędzy V-Sync (z i bez) oraz G-Sync - pozwala nie tylko na ustawienie rozdzielczości, ale i framrate’u, dlatego idealnie nadaje się jako narzędzie sprawdzające, co dzieje się, kiedy zejdziemy poniżej zakresu FreeSync. Następnie na warsztat wzięliśmy kilka popularnych gier - od starego, ale wciąż jarego Crysisa 3 i Monster Hunter World, przez Battlefielda V i Rise of the Tomb Raider, po Wiedźmina 3: Dziki Gon i Just Cause 4.

A jak wrażenia? Świetnie, ponieważ FreeSync na kartach GeForce działa w gruncie rzeczy identycznie jak na Radeonach, co oznacza, że NVIDIA przyłożyła się do implementacji wsparcia tego standardu. Posiadając monitor z technologią AMD i peceta z grafiką Zielonych nie musimy więc obawiać się stutteringu czy rozrywania obrazu, co z punktu widzenia graczy jest świetną informacją. Co warto podkreślić, NVIDIA zadbała także o należyte wsparcie dla LFC, które było dostępne w naszym monitorze, dzięki czemu nie musieliśmy martwić się o spadki poniżej granicznej wartości FreeSync dla tego modelu (48 kl./s), ponieważ w takim przypadku klatka była duplikowana, pozwalając tym samym wskoczyć w odpowiedni zakres. Jest to funkcja, która dostępna jest dla wszystkich monitorów G-Sync, ale nie wszystkie modele FreeSync ją posiadają, dlatego tym większe brawa, że producent GeForce’ów pozwolił na jej obsługę. W sytuacji, kiedy posiadamy monitor o wąskim zakresie obsługiwania FreeSync, np. 40-60 Hz (często spotykane w monitorach 4K), przeważnie musimy obyć się bez LFC, więc zejście poniżej 40 kl./s skutkować będzie tearingiem i stutteringiem. Chyba nie trzeba tłumaczyć każdemu, kto miał do czynienia z synchronizacją adaptacyjną, jakie korzyści przynosi ta technologia, gdyż spadki framerate’u w zakresie obsługiwania standardu, o ile nie są dramatyczne, są bardzo trudne do wychwycenia, a my możemy cieszyć się niezwykle płynną rozgrywką bez dodatkowych opóźnień. Sprawdziliśmy także, czy FreeSync w tym przypadku nie wpływa na input laga, ale tu także nie ma powodów do obaw, gdyż ten pozostaje bez zmian - podobnie jak obsługa HDR, która nie cierpi z tego tytułu. Monitor spisywał się bez zarzutu i praktycznie nie było się do czego przyczepić. Trzeba też pamiętać, że produkt Gigabyte dopiero wchodzi na rynek i NVIDIA nie zdążyła zapewne jeszcze go przetestować, więc jest szansa, że otrzyma on stosowny certyfikat kompatybilności z G-Sync. Z ciekawości postanowiliśmy zatem sprawdzić jeszcze jeden, starszy i zdecydowanie tańszy model, a mianowicie AOC C32G1 i... rezultaty okazały się być identyczne.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

FreeSync na kartach graficznych NVIDII? Sprawdzamy czy to działa