Zanim przejdę do meritum sprawy, pozwolę sobie jeszcze na krótki rys historyczny odnośnie procesorów wielordzeniowych. Etap ten, w przypadku jednostek przeznaczonych do użytku domowego, rozpoczął się w maju 2005 roku, kiedy firma AMD wydała Athlony 64 X2, natomiast Intel wprowadził Pentiumy D. Jak wszyscy dobrze pamiętamy, starcie to wygrali zdecydowanie czerwoni, gdyż po prostu mieli lepszą architekturę. NetBurst okazała się ślepą uliczką, z której trudno było się Intelowi wydostać. Z zakładanych 10 GHz, udało się uzyskać maksymalnie 3,8 GHz, co - przy kiepskich osiągach na takt zegara - nie mogło zapewnić wysokiej wydajności. Ponadto, liczne zmiany poczynione przy rodzinie Prescott również nie okazały się strzałem w dziesiątkę, gdyż czasami powodowały wręcz spadek wydajności, a procesory te trapione były problemami z ogromnym poborem prądu. Koniec końców, niebiescy porzucili tonący okręt, przedstawiając światu rodzinę Core 2 Duo (lipiec 2006 roku). Z punktu widzenia wielordzeniowości, istotniejszą datą jest jednak listopad 2006 roku, kiedy to pojawiły się czterordzeniowe Core 2 Quad. Na odpowiedź AMD musieliśmy czekać okrągły rok, po którym firma przedstawiła serię Phenom. Wygrana, podobnie jak przy rywalizacji Core 2 Duo z Athlonami 64 X2, padła łupem niebieskich, w dużej mierze za sprawą ogromnych problemów, jakie miały pierwsze Phenomy z uzyskiwaniem zegarów powyżej 3 GHz. Ten ostatni defekt naprawiła dopiero rodzina Phenom II, która pojawiła się w styczniu 2009 roku, a więc już po premierze Nehalema... Pomimo tego, nowa propozycja AMD była całkiem konkurencyjną alternatywą dla Core 2 Quad i to właśnie z nimi rywalizowała, wobec wysokich cen Core i7 (jako całej platformy).

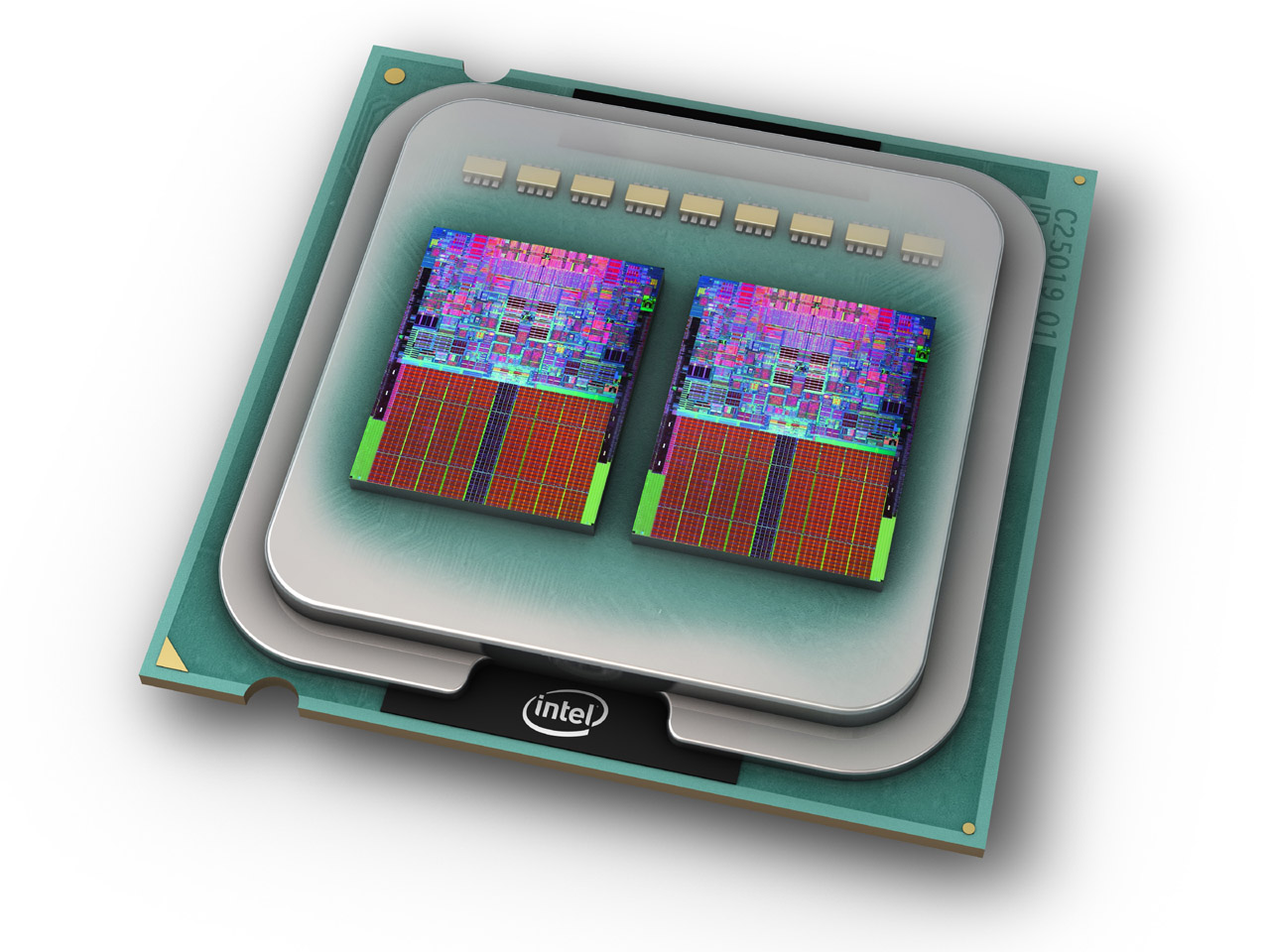

Historia wielordzeniowych procesorów dla użytkowników domowych rozpoczęła się w maju 2005 roku, kiedy pojawiły się Athlony 64 X2 oraz Pentiumy D. Od tego czasu, producenci sukcesywnie zwiększali liczbę rdzeni w kolejnych generacjach.

Następne podniesienie poprzeczki nastąpiło w marcu 2010 roku, w postaci sześciordzeniowych Core i7 (nazwa kodowa Gulftown) dla platformy LGA 1366. Odpowiedź AMD była niemal natychmiastowa - Phenom II X6 zadebiutował miesiąc później. Dalsze zwiększanie liczby rdzeni, jeśli chodzi o Intela, następowało wyłącznie w segmencie HEDT. LGA 1156, czyli tańsza wersja LGA 1366, ograniczona była do czterech sztuk. Podobnie zresztą jak następcy, zaczynając od Sandy Bridge, a na Skylake kończąc. Wracając do wagi ciężkiej, osiem rdzeni od niebieskich zobaczyliśmy w kwietniu 2014 roku, za sprawą Core i7-5960X z rodziny Haswell-E. Następczyni tej ostatniej, Broadwell-E, do sklepów trafiła w maju 2016 roku i zaoferowała nawet dziesięć rdzeni. Z kolei w czerwonym obozie, okres między premierą Phenoma II X6 a pojawieniem się pierwszych Ryzenów upłynął na jednostkach modułowych, czyli niesławnych "buldożerach". Procesory te pojawiły się relatywnie późno, bowiem dopiero w październiku 2011 roku, przez co na starcie musiały rywalizować z ciepło przyjętą, naprawdę udaną serią Sandy Bridge od Intela. Pierwsze ośmiordzeniowe jednostki na architekturze Bulldozer okazały się prądożerne, zaś wydajnościowo niezwykle nierówne. Pewną poprawę przyniosło odświeżenie, w postaci serii Piledriver, gdzie obniżono zapotrzebowanie na energię elektryczną oraz zwiększono wydajność na takt zegara. Mimo wszystko, to zdecydowanie nie było to, na co fani czerwonych czekali. Podobnie jak intelowska NetBurst, architektura Bulldozer okazała się ślepym zaułkiem. Identyczna była również reakcja - "buldożera" porzucono, jak tylko prace nad Zen dobiegły końca. A dalszy ciąg tej historii, jak mniemam, znacie już bardzo dobrze.

Spodobało Ci się? Podziel się ze znajomymi!

Pokaż / Dodaj komentarze do:

Ile rdzeni potrzeba do grania, czyli jak gry radzą sobie z nowoczesnymi CPU